ChatGPT OpenAI stanowi znaczący krok w technologii AI. Ten wysoce wyrafinowany chatbot, oparty na modelu języka GPT-3, jest teraz dostępny dla odbiorców na całym świecie.

ChatGPT wyróżnia się jako inteligentne narzędzie konwersacyjne, przeszkolone na szerokim zakresie danych. Dzięki temu można go wyjątkowo przystosować i sprostać niezliczonym wyzwaniom w różnych dziedzinach.

Celem tego przewodnika jest poinstruowanie Cię, jak używać ChatGPT do tworzenia skutecznych skrobaków sieciowych w Pythonie. Dodatkowo zapewnimy niezbędne wskazówki i techniki umożliwiające udoskonalenie i podniesienie poziomu programowania skrobaka.

Rozpocznijmy eksplorację wykorzystania ChatGPT do przeglądania stron internetowych, odkrywając jego potencjalne i praktyczne zastosowania.

Implementacja Web Scrapingu poprzez ChatGPT

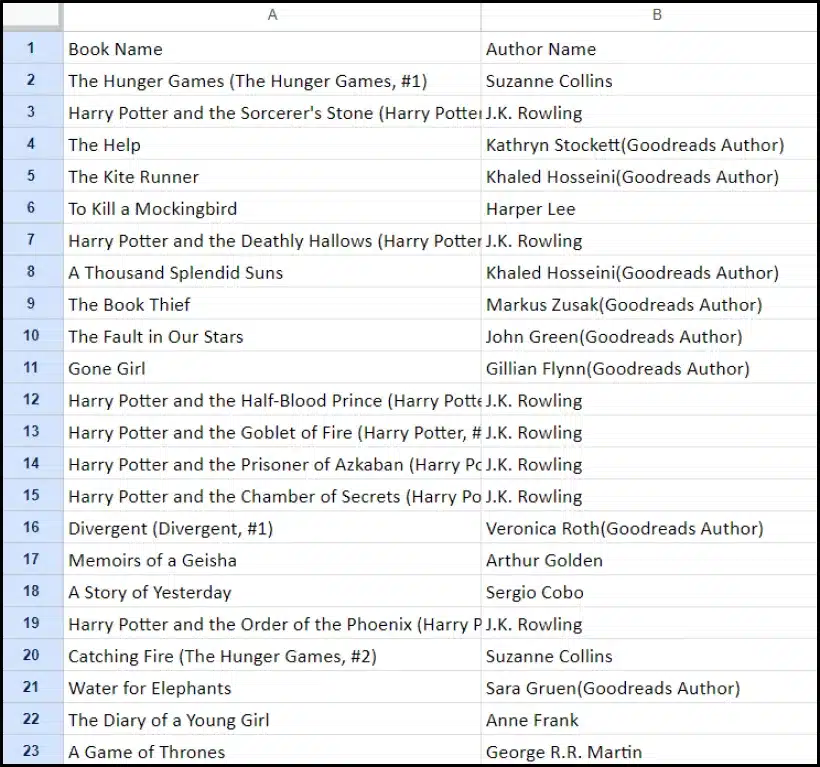

Ten samouczek przeprowadzi Cię przez proces wyodrębniania listy książek z goodreads.com. Aby pomóc Ci w zrozumieniu, przedstawimy wizualną reprezentację układu strony witryny.

Następnie przedstawiamy najważniejsze kroki niezbędne do skutecznego gromadzenia danych przy użyciu ChatGPT.

Zakładanie konta ChatGPT

Proces zakładania konta ChatGPT jest prosty. Przejdź do strony logowania ChatGPT i wybierz opcję rejestracji. Alternatywnie, dla większej wygody możesz zarejestrować się przy użyciu konta Google.

Po zakończeniu rejestracji uzyskasz dostęp do interfejsu czatu. Rozpoczęcie rozmowy jest tak proste, jak wpisanie zapytania lub wiadomości w odpowiednim polu tekstowym.

Tworzenie skutecznego monitu dla ChatGPT

Kiedy szukasz pomocy ChatGPT w zadaniach programistycznych, takich jak przeglądanie stron internetowych, najważniejsza jest przejrzystość i szczegółowość podpowiedzi. Wyraźnie określ język programowania wraz ze wszystkimi niezbędnymi narzędziami i bibliotekami. Dodatkowo jasno określ konkretne elementy strony internetowej, z którą zamierzasz pracować.

Równie ważne jest określenie pożądanego rezultatu programu oraz wszelkich konkretnych standardów kodowania lub wymagań, których należy przestrzegać.

Rozważmy na przykład ten przykładowy monit z prośbą o opracowanie skrobaka sieciowego w języku Python wykorzystującego bibliotekę BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.Następnie ChatGPT powinien wygenerować odpowiedni fragment kodu.

Ocena wygenerowanego kodu

Gdy ChatGPT udostępni kod, bardzo ważne jest jego dokładne przejrzenie. Sprawdź, czy nie zawiera zbędnych bibliotek i potwierdź, że dostępne są wszystkie niezbędne pakiety, aby kod działał poprawnie.

Jeśli napotkasz jakiekolwiek problemy lub rozbieżności w kodzie, nie wahaj się skontaktować z ChatGPT w celu wprowadzenia poprawek lub całkowitego przepisania, jeśli to konieczne.

Implementacja skrobaka

Po sprawdzeniu skopiuj dostarczony kod i przeprowadź uruchomienie próbne, aby upewnić się, że działa prawidłowo. Oto przykład, jak może wyglądać kod skrobaka sieciowego.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")Przykładowe dane wyjściowe zeskrobanych danych podano poniżej.

Ulepszanie projektu skrobania sieci za pomocą ChatGPT: zaawansowane techniki i rozważania

Poczyniłeś znaczne postępy, opracowując skrobak sieciowy w języku Python przy użyciu BeautifulSoup, co widać w dostarczonym kodzie. Ten skrypt jest doskonałym punktem wyjścia do wydajnego gromadzenia danych z określonej strony internetowej Goodreads. Zagłębmy się teraz w kilka zaawansowanych aspektów, aby jeszcze bardziej ulepszyć projekt skrobania stron internetowych.

Optymalizacja kodu pod kątem wydajności

Wydajny kod jest niezbędny do pomyślnego przeglądania stron internetowych, szczególnie w przypadku zadań na dużą skalę. Aby zwiększyć wydajność skrobaka, rozważ następujące strategie:

- Ramy i pakiety dźwigni: Zasięgnij porady na temat frameworków i pakietów, które mogą przyspieszyć skrobanie sieci.

- Wykorzystaj techniki buforowania: Zaimplementuj buforowanie, aby zapisać wcześniej pobrane dane, redukując zbędne połączenia sieciowe.

- Stosuj przetwarzanie współbieżne lub równoległe: Takie podejście może znacznie przyspieszyć pobieranie danych poprzez obsługę wielu zadań jednocześnie.

- Zminimalizuj niepotrzebne połączenia sieciowe: Skoncentruj się na pobieraniu tylko niezbędnych danych, aby zoptymalizować wykorzystanie sieci.

Obsługa dynamicznych treści internetowych

Wiele nowoczesnych stron internetowych wykorzystuje techniki dynamicznego generowania treści, często opierając się na JavaScript. Oto kilka sposobów, w jakie ChatGPT może pomóc Ci w poruszaniu się po takich zawiłościach:

- Skorzystaj z przeglądarek Headless: ChatGPT może pomóc Ci w korzystaniu z bezgłowych przeglądarek do skrobania treści dynamicznych.

- Automatyzuj interakcje użytkowników: Symulowane działania użytkownika można zautomatyzować w celu interakcji ze stronami internetowymi o złożonym interfejsie użytkownika.

Linting i edycja kodu

Utrzymanie czystego i czytelnego kodu jest kluczowe. ChatGPT może pomóc na kilka sposobów:

- Zaproponuj najlepsze praktyki: ChatGPT może polecić standardy i praktyki kodowania w celu zwiększenia czytelności i wydajności.

- Lintuj swój kod: Poproś ChatGPT o „lintowanie kodu” w celu uzyskania sugestii dotyczących uporządkowania i optymalizacji skryptu.

Pokonywanie ograniczeń dzięki usługom proxy

Chociaż ChatGPT to potężne narzędzie, należy pamiętać o ograniczeniach podczas pobierania danych internetowych z witryn o rygorystycznych środkach bezpieczeństwa. Aby stawić czoła wyzwaniom, takim jak CAPTCHA i ograniczanie szybkości, rozważ skorzystanie z usług proxy, takich jak OneProxy. Oni oferują:

- Wysokiej jakości pula serwerów proxy: Dostęp do puli premium serwerów proxy o doskonałej reputacji i wydajności.

- Niezawodne odzyskiwanie danych: Zapewnienie, że Twoje żądania nie będą ograniczone stawką, utrzymując w ten sposób spójny dostęp do wymaganych danych.

Zastosowanie OneProxy w Web Scrapingu

Korzystanie z OneProxy może znacząco zwiększyć możliwości przeglądania stron internetowych. Kierując żądania przez różne serwery proxy, możesz:

- Ograniczanie szybkości obejścia i CAPTCHA: OneProxy może pomóc w obejściu powszechnych środków zapobiegających skrobaniu.

- Uzyskaj dostęp do dokładnych i nieograniczonych danych internetowych: Dzięki solidnej sieci proxy OneProxy zapewnia niezawodny i nieprzerwany dostęp do danych.

Łącząc moc ChatGPT ze strategicznym wykorzystaniem narzędzi takich jak OneProxy i stosując się do najlepszych praktyk w zakresie kodowania i skrobania sieci, możesz wydajnie i skutecznie gromadzić potrzebne dane z szerokiej gamy źródeł internetowych.

Wniosek: uwolnienie mocy ChatGPT w scrapowaniu sieci

Podsumowując, ChatGPT jawi się jako kluczowe narzędzie w dziedzinie web scrapingu, oferując na pierwszy plan wiele możliwości. Jego możliwości w zakresie generowania, udoskonalania i ulepszania kodu są niezbędne zarówno dla początkujących, jak i doświadczonych skrobaków internetowych.

Rola ChatGPT w przeglądaniu stron internetowych nie ogranicza się tylko do generowania kodu; rozciąga się na dostarczanie wnikliwych wskazówek, obsługę złożonych stron internetowych, a nawet doradzanie w zakresie najlepszych praktyk w zakresie wydajnego skrobania. Wraz z rozwojem technologii wkład ChatGPT w upraszczanie i udoskonalanie zadań związanych z przeglądaniem stron internetowych staje się coraz bardziej istotny.

Oznacza to nową erę, w której skrobanie sieci, obsługiwane przez zaawansowane narzędzia AI, takie jak ChatGPT, staje się bardziej dostępne, wydajne i skuteczne dla szerokiego grona użytkowników, od indywidualnych hobbystów po analityków danych na dużą skalę.

Życzymy udanych i innowacyjnych przedsięwzięć związanych ze skrobaniem w przyszłości – Wszystkiego najlepszego z okazji skrobania!