ChatGPT von OpenAI stellt einen bedeutenden Sprung in der KI-Technologie dar. Dieser hochentwickelte Chatbot, der auf dem GPT-3-Sprachmodell basiert, ist jetzt für ein globales Publikum zugänglich.

ChatGPT zeichnet sich als intelligentes Konversationstool aus, da es auf einer umfassenden Datenpalette trainiert wurde. Dies macht es außergewöhnlich anpassungsfähig und in der Lage, unzählige Herausforderungen in einem breiten Spektrum von Bereichen zu bewältigen.

Dieser Leitfaden soll Sie in die Verwendung von ChatGPT zum Erstellen effektiver Python-Web-Scraper einweisen. Darüber hinaus stellen wir Ihnen wichtige Tipps und Techniken zur Verfügung, um die Programmierung Ihres Scrapers zu verfeinern und zu verbessern.

Beginnen wir mit der Erkundung der Verwendung von ChatGPT für das Web-Scraping und entdecken wir dessen Potenzial und praktische Anwendungen.

Implementierung von Web Scraping über ChatGPT

Dieses Tutorial führt Sie durch den Prozess zum Extrahieren einer Liste von Büchern von goodreads.com. Wir präsentieren eine visuelle Darstellung des Seitenlayouts der Website, um Ihnen das Verständnis zu erleichtern.

Als Nächstes skizzieren wir die entscheidenden Schritte, die zur effektiven Datenerfassung mit ChatGPT erforderlich sind.

Einrichten eines ChatGPT-Kontos

Das Einrichten eines ChatGPT-Kontos ist unkompliziert. Navigieren Sie zur ChatGPT-Anmeldeseite und wählen Sie die Anmeldeoption. Alternativ können Sie sich für zusätzlichen Komfort auch mit Ihrem Google-Konto anmelden.

Nach Abschluss der Registrierung erhalten Sie Zugriff auf die Chat-Oberfläche. Um ein Gespräch zu beginnen, müssen Sie lediglich Ihre Anfrage oder Nachricht in das dafür vorgesehene Textfeld eingeben.

Erstellen einer effektiven Eingabeaufforderung für ChatGPT

Wenn Sie die Unterstützung von ChatGPT bei Programmieraufgaben wie Web-Scraping in Anspruch nehmen, sind Klarheit und Details in Ihrer Eingabeaufforderung von größter Bedeutung. Geben Sie explizit die Programmiersprache sowie alle erforderlichen Tools oder Bibliotheken an. Identifizieren Sie außerdem eindeutig bestimmte Elemente der Webseite, mit denen Sie arbeiten möchten.

Ebenso wichtig ist es, das gewünschte Ergebnis des Programms und alle spezifischen Codierungsstandards oder -anforderungen anzugeben, die eingehalten werden müssen.

Betrachten Sie zum Beispiel diese beispielhafte Aufforderung, in der die Entwicklung eines Python-Web-Scrapers unter Verwendung der BeautifulSoup-Bibliothek gefordert wird.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.Anschließend sollte von ChatGPT ein passendes Code-Snippet generiert werden.

Auswertung des generierten Codes

Sobald ChatGPT den Code bereitstellt, ist es wichtig, ihn gründlich zu prüfen. Stellen Sie sicher, dass keine überflüssigen Bibliotheken enthalten sind, und stellen Sie sicher, dass alle erforderlichen Pakete verfügbar sind, damit der Code ordnungsgemäß funktioniert.

Wenn Sie auf Probleme oder Unstimmigkeiten mit dem Code stoßen, zögern Sie nicht, sich an ChatGPT zu wenden, um gegebenenfalls Anpassungen oder eine vollständige Neufassung vorzunehmen.

Implementierung Ihres Scrapers

Kopieren Sie nach der Überprüfung den bereitgestellten Code und führen Sie einen Testlauf durch, um sicherzustellen, dass er ordnungsgemäß funktioniert. Hier ist ein Beispiel dafür, wie der Web-Scraper-Code aussehen könnte.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

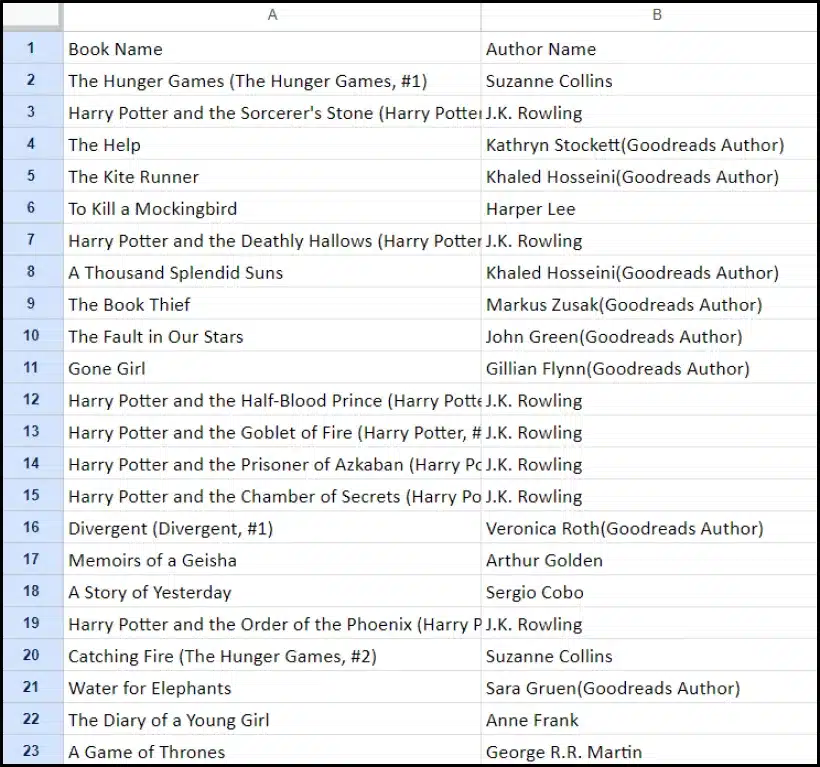

print(f"Failed to retrieve data. Status code: {response.status_code}")Die Beispielausgabe der gescrapten Daten ist unten angegeben.

Verbessern Sie Ihr Web-Scraping-Projekt mit ChatGPT: Fortgeschrittene Techniken und Überlegungen

Sie haben durch die Entwicklung eines Python-Web-Scrapers mit BeautifulSoup erhebliche Fortschritte gemacht, wie aus dem bereitgestellten Code hervorgeht. Dieses Skript ist ein hervorragender Ausgangspunkt für die effiziente Datenerfassung von der angegebenen Goodreads-Webseite. Lassen Sie uns nun auf einige fortgeschrittene Aspekte eingehen, um Ihr Web-Scraping-Projekt weiter zu verbessern.

Optimieren Sie Ihren Code für mehr Effizienz

Effizienter Code ist für erfolgreiches Web Scraping von entscheidender Bedeutung, insbesondere bei umfangreichen Aufgaben. Um die Leistung Ihres Schabers zu verbessern, sollten Sie die folgenden Strategien in Betracht ziehen:

- Nutzen Sie Frameworks und Pakete: Lassen Sie sich zu Frameworks und Paketen beraten, die das Web Scraping beschleunigen können.

- Nutzen Sie Caching-Techniken: Implementieren Sie Caching, um zuvor abgerufene Daten zu speichern und so redundante Netzwerkaufrufe zu reduzieren.

- Nutzen Sie Parallelität oder Parallelverarbeitung: Dieser Ansatz kann den Datenabruf erheblich beschleunigen, indem mehrere Aufgaben gleichzeitig erledigt werden.

- Minimieren Sie unnötige Netzwerkanrufe: Konzentrieren Sie sich darauf, nur die wesentlichen Daten abzurufen, um die Netzwerknutzung zu optimieren.

Umgang mit dynamischen Webinhalten

Viele moderne Websites verwenden Techniken zur dynamischen Inhaltsgenerierung, die häufig auf JavaScript basieren. Hier sind einige Möglichkeiten, wie ChatGPT Sie bei der Bewältigung solcher Komplexitäten unterstützen kann:

- Nutzen Sie Headless-Browser: ChatGPT kann Sie bei der Verwendung von Headless-Browsern zum Scrapen dynamischer Inhalte unterstützen.

- Automatisieren Sie Benutzerinteraktionen: Simulierte Benutzeraktionen können automatisiert werden, um mit Webseiten zu interagieren, die über komplexe Benutzeroberflächen verfügen.

Code-Linting und -Bearbeitung

Die Aufrechterhaltung eines sauberen, lesbaren Codes ist von entscheidender Bedeutung. ChatGPT kann auf verschiedene Weise helfen:

- Schlagen Sie Best Practices vor: ChatGPT kann Codierungsstandards und -praktiken empfehlen, um die Lesbarkeit und Effizienz zu verbessern.

- Flusen Sie Ihren Code: Bitten Sie ChatGPT, den Code zu „linten“, um Vorschläge zur Aufräumung und Optimierung Ihres Skripts zu erhalten.

Überwindung von Einschränkungen mit Proxy-Diensten

Obwohl ChatGPT ein leistungsstarkes Tool ist, ist es wichtig, die Einschränkungen beim Scraping von Webdaten von Websites mit strengen Sicherheitsmaßnahmen zu berücksichtigen. Um Herausforderungen wie CAPTCHAs und Ratenbegrenzung zu bewältigen, sollten Sie die Verwendung von Proxy-Diensten wie OneProxy in Betracht ziehen. Sie bieten an:

- Hochwertiger Proxy-Pool: Zugriff auf einen Premium-Pool von Proxys mit ausgezeichnetem Ruf und hervorragender Leistung.

- Zuverlässiger Datenabruf: Stellen Sie sicher, dass Ihre Anfragen keiner Geschwindigkeitsbeschränkung unterliegen und Sie so einen durchgängigen Zugriff auf die erforderlichen Daten haben.

Anwendung von OneProxy beim Web Scraping

Durch die Verwendung von OneProxy können Sie Ihre Web-Scraping-Funktionen erheblich verbessern. Indem Sie Ihre Anfragen über verschiedene Proxys weiterleiten, können Sie:

- Bypass-Ratenbegrenzung und CAPTCHAs: OneProxy kann dabei helfen, gängige Anti-Scraping-Maßnahmen zu umgehen.

- Greifen Sie auf genaue und unbegrenzte Webdaten zu: Mit einem robusten Proxy-Netzwerk gewährleistet OneProxy einen zuverlässigen und unterbrechungsfreien Datenzugriff.

Durch die Kombination der Leistungsfähigkeit von ChatGPT mit dem strategischen Einsatz von Tools wie OneProxy und der Einhaltung bewährter Methoden beim Codieren und Web-Scraping können Sie die benötigten Daten effizient und effektiv aus einer Vielzahl von Webquellen sammeln.

Fazit: Die Leistungsfähigkeit von ChatGPT beim Web Scraping freisetzen

Zusammenfassend lässt sich sagen, dass sich ChatGPT zu einem zentralen Tool im Bereich Web Scraping entwickelt, das eine Vielzahl von Möglichkeiten in den Vordergrund stellt. Seine Fähigkeiten zum Generieren, Verfeinern und Verbessern von Code sind sowohl für Anfänger als auch für erfahrene Web-Scraper unverzichtbar.

Die Rolle von ChatGPT beim Web Scraping beschränkt sich nicht nur auf die Codegenerierung; Es umfasst die Bereitstellung aufschlussreicher Tipps, den Umgang mit komplexen Webseiten und sogar die Beratung zu Best Practices für effizientes Scraping. Mit der Weiterentwicklung der Technologie wird der Beitrag von ChatGPT zur Vereinfachung und Weiterentwicklung von Web-Scraping-Aufgaben immer wichtiger.

Dies markiert eine neue Ära, in der Web Scraping, unterstützt durch fortschrittliche KI-Tools wie ChatGPT, für ein breites Spektrum von Benutzern zugänglicher, effizienter und effektiver wird, vom einzelnen Hobbyanwender bis zum großen Datenanalysten.

Auf erfolgreiche und innovative Scraping-Unternehmungen in der Zukunft – Happy Scraping!