ChatGPT ของ OpenAI แสดงให้เห็นถึงการก้าวกระโดดครั้งสำคัญในเทคโนโลยี AI แชทบอตที่มีความซับซ้อนสูงซึ่งขับเคลื่อนด้วยโมเดลภาษา GPT-3 เปิดให้ผู้ชมทั่วโลกเข้าถึงได้แล้ว

ChatGPT โดดเด่นในฐานะเครื่องมือสนทนาอัจฉริยะ โดยได้รับการฝึกอบรมเกี่ยวกับข้อมูลที่ครอบคลุม ทำให้สามารถปรับเปลี่ยนได้เป็นพิเศษ สามารถรับมือกับความท้าทายมากมายในสาขาต่างๆ

คู่มือนี้มีจุดมุ่งหมายเพื่อแนะนำให้คุณใช้ ChatGPT เพื่อสร้างเว็บสแครปเปอร์ Python ที่มีประสิทธิภาพ นอกจากนี้ เราจะให้คำแนะนำและเทคนิคที่จำเป็นในการปรับแต่งและยกระดับความสามารถของการเขียนโปรแกรมขูดของคุณ

เรามาเริ่มสำรวจการใช้ ChatGPT สำหรับการขูดเว็บ เพื่อเปิดเผยศักยภาพและการใช้งานจริงของ ChatGPT กัน

การใช้ Web Scraping ผ่าน ChatGPT

บทช่วยสอนนี้จะแนะนำคุณตลอดกระบวนการดึงรายชื่อหนังสือจาก goodreads.com เราจะนำเสนอภาพเค้าโครงหน้าของเว็บไซต์เพื่อช่วยให้คุณเข้าใจ

ต่อไป เราจะร่างขั้นตอนสำคัญที่จำเป็นในการเก็บเกี่ยวข้อมูลโดยใช้ ChatGPT อย่างมีประสิทธิภาพ

การตั้งค่าบัญชี ChatGPT

ขั้นตอนการตั้งค่าบัญชี ChatGPT ตรงไปตรงมา ไปที่หน้าเข้าสู่ระบบ ChatGPT และเลือกตัวเลือกการลงทะเบียน หรืออีกวิธีหนึ่ง เพื่อความสะดวกยิ่งขึ้น คุณสามารถเลือกลงทะเบียนโดยใช้บัญชี Google ของคุณได้

เมื่อลงทะเบียนเสร็จสิ้น คุณจะสามารถเข้าถึงอินเทอร์เฟซการแชท การเริ่มต้นการสนทนานั้นง่ายดายเพียงแค่ป้อนคำถามหรือข้อความของคุณลงในกล่องข้อความที่ให้ไว้

การสร้างพรอมต์ที่มีประสิทธิภาพสำหรับ ChatGPT

เมื่อขอความช่วยเหลือจาก ChatGPT ในงานเขียนโปรแกรม เช่น การขูดเว็บ ความชัดเจนและรายละเอียดในข้อความแจ้งของคุณเป็นสิ่งสำคัญที่สุด ระบุภาษาการเขียนโปรแกรมอย่างชัดเจน พร้อมด้วยเครื่องมือหรือไลบรารีที่จำเป็น นอกจากนี้ ระบุองค์ประกอบเฉพาะของหน้าเว็บที่คุณต้องการใช้งานอย่างชัดเจน

สิ่งสำคัญเท่าเทียมกันคือการระบุผลลัพธ์ที่ต้องการของโปรแกรมและมาตรฐานการเข้ารหัสเฉพาะหรือข้อกำหนดที่ต้องปฏิบัติตาม

ตัวอย่างเช่น พิจารณาพรอมต์ที่เป็นแบบอย่างนี้เพื่อขอการพัฒนา Python web scraper โดยใช้ไลบรารี BeautifulSoup

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.หลังจากนี้ ChatGPT ควรสร้างข้อมูลโค้ดที่เหมาะสม

การประเมินรหัสที่สร้างขึ้น

เมื่อ ChatGPT ให้โค้ดแล้ว การตรวจสอบอย่างละเอียดก็เป็นสิ่งสำคัญ ตรวจสอบว่าไม่มีไลบรารี่ที่ไม่จำเป็น และยืนยันว่ามีแพ็คเกจที่จำเป็นทั้งหมดเพื่อให้โค้ดทำงานได้อย่างถูกต้อง

หากคุณพบปัญหาหรือความคลาดเคลื่อนกับโค้ด โปรดติดต่อ ChatGPT เพื่อปรับเปลี่ยนหรือเขียนใหม่ทั้งหมดหากจำเป็น

การใช้เครื่องขูดของคุณ

หลังจากตรวจสอบแล้ว ให้คัดลอกโค้ดที่ให้มาและทดลองใช้งานเพื่อให้แน่ใจว่าโค้ดทำงานได้อย่างเหมาะสม ต่อไปนี้เป็นตัวอย่างลักษณะของโค้ดขูดเว็บ

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

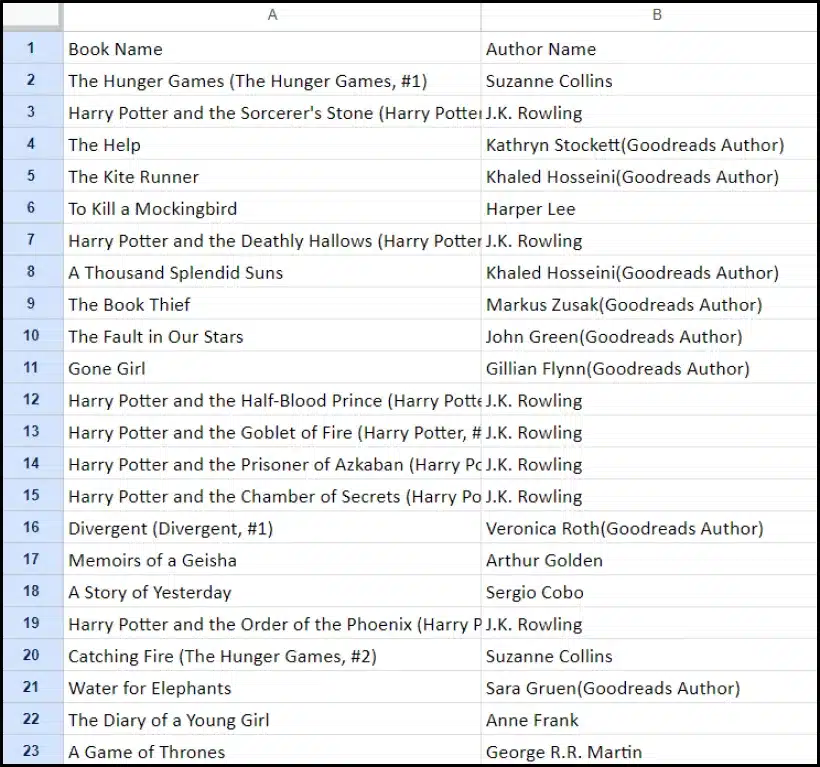

print(f"Failed to retrieve data. Status code: {response.status_code}")ผลลัพธ์ตัวอย่างของข้อมูลที่คัดลอกมาแสดงไว้ด้านล่าง

ปรับปรุงโครงการขูดเว็บของคุณด้วย ChatGPT: เทคนิคขั้นสูงและข้อควรพิจารณา

คุณได้ก้าวหน้าไปอย่างมากโดยการพัฒนา Python web scraper โดยใช้ BeautifulSoup ดังที่เห็นได้ชัดในโค้ดที่ให้มา สคริปต์นี้เป็นจุดเริ่มต้นที่ดีเยี่ยมสำหรับการเก็บเกี่ยวข้อมูลจากหน้าเว็บ Goodreads ที่ระบุอย่างมีประสิทธิภาพ ตอนนี้ เรามาเจาะลึกแง่มุมขั้นสูงบางอย่างเพื่อปรับปรุงโครงการขูดเว็บของคุณให้ดียิ่งขึ้น

เพิ่มประสิทธิภาพโค้ดของคุณเพื่อประสิทธิภาพ

โค้ดที่มีประสิทธิภาพมีความสำคัญต่อการขูดเว็บให้ประสบความสำเร็จ โดยเฉพาะสำหรับงานขนาดใหญ่ เพื่อเพิ่มประสิทธิภาพการทำงานของมีดโกน ให้พิจารณากลยุทธ์ต่อไปนี้:

- ใช้ประโยชน์จากกรอบงานและแพ็คเกจ: ขอคำแนะนำเกี่ยวกับเฟรมเวิร์กและแพ็คเกจที่สามารถเร่งการขูดเว็บได้

- ใช้เทคนิคการแคช: ใช้แคชเพื่อบันทึกข้อมูลที่ดึงมาก่อนหน้านี้ ลดการเรียกเครือข่ายซ้ำซ้อน

- ใช้การประมวลผลพร้อมกันหรือการประมวลผลแบบขนาน: วิธีการนี้สามารถเร่งความเร็วในการดึงข้อมูลได้อย่างมากโดยการจัดการงานหลายอย่างพร้อมกัน

- ลดการโทรผ่านเครือข่ายที่ไม่จำเป็น: มุ่งเน้นไปที่การดึงข้อมูลที่จำเป็นเท่านั้นเพื่อเพิ่มประสิทธิภาพการใช้งานเครือข่าย

การจัดการเนื้อหาเว็บแบบไดนามิก

เว็บไซต์สมัยใหม่หลายแห่งใช้เทคนิคการสร้างเนื้อหาแบบไดนามิก ซึ่งมักอาศัย JavaScript ต่อไปนี้คือวิธีที่ ChatGPT สามารถช่วยคุณจัดการกับความซับซ้อนดังกล่าวได้:

- ใช้เบราว์เซอร์ Headless: ChatGPT สามารถแนะนำคุณในการใช้เบราว์เซอร์ที่ไม่มีส่วนหัวในการคัดลอกเนื้อหาแบบไดนามิก

- โต้ตอบกับผู้ใช้โดยอัตโนมัติ: การกระทำของผู้ใช้จำลองสามารถดำเนินการได้โดยอัตโนมัติเพื่อโต้ตอบกับหน้าเว็บที่มีอินเทอร์เฟซผู้ใช้ที่ซับซ้อน

การ Linting และการแก้ไขโค้ด

การรักษาโค้ดให้สะอาดและอ่านง่ายถือเป็นสิ่งสำคัญ ChatGPT สามารถช่วยได้หลายวิธี:

- แนะนำแนวทางปฏิบัติที่ดีที่สุด: ChatGPT สามารถแนะนำมาตรฐานและแนวทางปฏิบัติในการเขียนโค้ดเพื่อเพิ่มความสามารถในการอ่านและประสิทธิภาพได้

- ขลิบรหัสของคุณ: ขอให้ ChatGPT 'lint the code' เพื่อรับคำแนะนำในการจัดระเบียบและเพิ่มประสิทธิภาพสคริปต์ของคุณ

เอาชนะข้อจำกัดด้วยบริการพร็อกซี

แม้ว่า ChatGPT จะเป็นเครื่องมือที่ทรงพลัง แต่ก็จำเป็นอย่างยิ่งที่จะต้องรับทราบข้อจำกัดในการดึงข้อมูลเว็บจากไซต์ที่มีมาตรการรักษาความปลอดภัยที่เข้มงวด หากต้องการจัดการกับความท้าทาย เช่น CAPTCHA และการจำกัดอัตรา ให้พิจารณาใช้บริการพร็อกซี เช่น OneProxy พวกเขาเสนอ:

- พร็อกซีพูลคุณภาพสูง: เข้าถึงกลุ่มพร็อกซีระดับพรีเมียมที่มีชื่อเสียงและประสิทธิภาพที่ยอดเยี่ยม

- การดึงข้อมูลที่เชื่อถือได้: ตรวจสอบให้แน่ใจว่าคำขอของคุณไม่ได้จำกัดอัตรา จึงทำให้สามารถเข้าถึงข้อมูลที่จำเป็นได้อย่างสม่ำเสมอ

การประยุกต์ใช้ OneProxy ในการขูดเว็บ

การใช้ OneProxy สามารถเพิ่มความสามารถในการขูดเว็บของคุณได้อย่างมาก ด้วยการกำหนดเส้นทางคำขอของคุณผ่านพร็อกซีต่างๆ คุณสามารถ:

- การจำกัดอัตราบายพาสและ CAPTCHA: OneProxy สามารถช่วยในการหลีกเลี่ยงมาตรการป้องกันการขูดทั่วไปได้

- เข้าถึงข้อมูลเว็บที่แม่นยำและไม่จำกัด: ด้วยเครือข่ายพร็อกซีที่แข็งแกร่ง OneProxy รับประกันการเข้าถึงข้อมูลที่เชื่อถือได้และไม่สะดุด

ด้วยการรวมพลังของ ChatGPT เข้ากับการใช้เครื่องมือเชิงกลยุทธ์ เช่น OneProxy และการปฏิบัติตามแนวทางปฏิบัติที่ดีที่สุดในการเขียนโค้ดและการขูดเว็บ คุณสามารถรวบรวมข้อมูลที่คุณต้องการจากแหล่งที่มาของเว็บต่างๆ ได้อย่างมีประสิทธิภาพและประสิทธิผล

สรุป: ปลดปล่อยพลังของ ChatGPT ใน Web Scraping

โดยสรุป ChatGPT กลายเป็นเครื่องมือสำคัญในขอบเขตของการขูดเว็บ ซึ่งนำโอกาสมากมายมาสู่แถวหน้า ความสามารถในการสร้าง ปรับแต่ง และเพิ่มประสิทธิภาพโค้ดเป็นสิ่งที่ขาดไม่ได้สำหรับทั้งผู้ขูดเว็บมือใหม่และผู้ที่มีประสบการณ์

บทบาทของ ChatGPT ในการขูดเว็บไม่ได้จำกัดอยู่เพียงการสร้างโค้ดเท่านั้น โดยครอบคลุมถึงการให้คำแนะนำเชิงลึก การจัดการหน้าเว็บที่ซับซ้อน และแม้แต่คำแนะนำเกี่ยวกับแนวทางปฏิบัติที่ดีที่สุดสำหรับการคัดลอกอย่างมีประสิทธิภาพ เมื่อเทคโนโลยีพัฒนาขึ้น การมีส่วนร่วมของ ChatGPT ในการทำให้งานขูดเว็บง่ายขึ้นและก้าวหน้าก็มีความสำคัญมากขึ้นเรื่อยๆ

นี่เป็นยุคใหม่ที่การขูดเว็บซึ่งขับเคลื่อนโดยเครื่องมือ AI ขั้นสูง เช่น ChatGPT สามารถเข้าถึงได้ มีประสิทธิภาพ และประสิทธิผลมากขึ้นสำหรับผู้ใช้ที่หลากหลาย ตั้งแต่ผู้ที่เป็นงานอดิเรกไปจนถึงนักวิเคราะห์ข้อมูลขนาดใหญ่

นี่คือความพยายามในการขูดที่ประสบความสำเร็จและเป็นนวัตกรรมใหม่ในอนาคต – Happy Scraping!