O ChatGPT da OpenAI representa um salto significativo na tecnologia de IA. Este chatbot altamente sofisticado, alimentado pelo modelo de linguagem GPT-3, está agora acessível a um público global.

O ChatGPT destaca-se como uma ferramenta conversacional inteligente, tendo sido treinado em uma ampla gama de dados. Isso o torna excepcionalmente adaptável, capaz de enfrentar uma infinidade de desafios em um espectro de campos.

Este guia tem como objetivo instruí-lo sobre como utilizar ChatGPT para construir web scrapers Python eficazes. Além disso, forneceremos dicas e técnicas essenciais para refinar e elevar o calibre da programação do seu scraper.

Vamos embarcar na exploração do uso do ChatGPT para web scraping, descobrindo seu potencial e aplicações práticas.

Implementando Web Scraping via ChatGPT

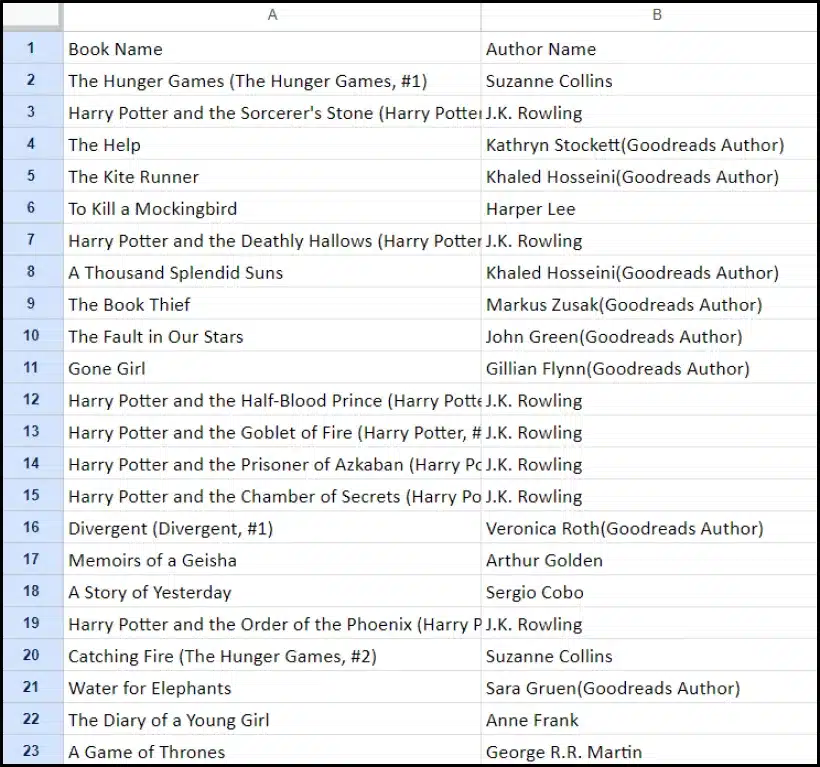

Este tutorial irá guiá-lo através do processo de extração de uma lista de livros de goodreads.com. Apresentaremos uma representação visual do layout da página do site para auxiliar sua compreensão.

A seguir, descrevemos as etapas críticas necessárias para coletar dados usando ChatGPT de forma eficaz.

Configurando uma conta ChatGPT

O processo de criação de uma conta ChatGPT é simples. Navegue até a página de login do ChatGPT e selecione a opção de inscrição. Alternativamente, para maior comodidade, você pode optar por se inscrever usando sua conta do Google.

Ao concluir o cadastro, você terá acesso à interface de chat. Iniciar uma conversa é tão simples quanto inserir sua consulta ou mensagem na caixa de texto fornecida.

Elaborando um prompt eficaz para ChatGPT

Ao buscar a assistência do ChatGPT em tarefas de programação, como web scraping, clareza e detalhes em seu prompt são fundamentais. Indique explicitamente a linguagem de programação, juntamente com quaisquer ferramentas ou bibliotecas necessárias. Além disso, identifique claramente elementos específicos da página da web com a qual pretende trabalhar.

Igualmente importante é especificar o resultado desejado do programa e quaisquer padrões ou requisitos de codificação específicos que precisam ser respeitados.

Por exemplo, considere este prompt exemplar solicitando o desenvolvimento de um web scraper Python utilizando a biblioteca BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.Depois disso, um trecho de código adequado deve ser gerado pelo ChatGPT.

Avaliando o código gerado

Depois que o ChatGPT fornecer o código, é crucial revisá-lo completamente. Verifique se não inclui bibliotecas supérfluas e confirme se todos os pacotes necessários estão disponíveis para que o código funcione corretamente.

Se você encontrar quaisquer problemas ou discrepâncias com o código, não hesite em entrar em contato com o ChatGPT para ajustes ou uma reescrita completa, se necessário.

Implementando seu raspador

Após a revisão, copie o código fornecido e realize um teste para garantir sua funcionalidade adequada. Aqui está um exemplo de como o código do web scraper pode parecer.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")O exemplo de saída dos dados extraídos é fornecido abaixo.

Aprimorando seu projeto de Web Scraping com ChatGPT: técnicas e considerações avançadas

Você fez um progresso significativo ao desenvolver um web scraper em Python usando BeautifulSoup, como fica evidente no código fornecido. Este script é um excelente ponto de partida para coletar dados com eficiência da página especificada do Goodreads. Agora, vamos nos aprofundar em alguns aspectos avançados para aprimorar ainda mais seu projeto de web scraping.

Otimizando Seu Código para Eficiência

Código eficiente é vital para web scraping bem-sucedido, especialmente para tarefas de grande escala. Para melhorar o desempenho do seu raspador, considere as seguintes estratégias:

- Aproveite estruturas e pacotes: Procure aconselhamento sobre estruturas e pacotes que podem acelerar o web scraping.

- Utilize técnicas de cache: Implemente o cache para salvar dados obtidos anteriormente, reduzindo chamadas de rede redundantes.

- Empregue simultaneidade ou processamento paralelo: Essa abordagem pode acelerar significativamente a recuperação de dados ao lidar com várias tarefas simultaneamente.

- Minimize chamadas de rede desnecessárias: Concentre-se em buscar apenas os dados essenciais para otimizar o uso da rede.

Lidando com conteúdo dinâmico da Web

Muitos sites modernos usam técnicas de geração de conteúdo dinâmico, muitas vezes contando com JavaScript. Aqui estão algumas maneiras pelas quais o ChatGPT pode ajudá-lo a navegar nessas complexidades:

- Utilize navegadores sem cabeça: ChatGPT pode orientá-lo no uso de navegadores headless para extrair conteúdo dinâmico.

- Automatize as interações do usuário: As ações simuladas do usuário podem ser automatizadas para interagir com páginas da web que possuem interfaces de usuário complexas.

Linting e edição de código

Manter um código limpo e legível é crucial. ChatGPT pode ajudar de várias maneiras:

- Sugira melhores práticas: ChatGPT pode recomendar padrões e práticas de codificação para melhorar a legibilidade e a eficiência.

- Lint seu código: Solicite ao ChatGPT que 'faça o código' para obter sugestões sobre como organizar e otimizar seu script.

Superando limitações com serviços de proxy

Embora o ChatGPT seja uma ferramenta poderosa, é essencial reconhecer as limitações ao extrair dados da web de sites com medidas de segurança rigorosas. Para enfrentar desafios como CAPTCHAs e limitação de taxa, considere usar serviços de proxy como o OneProxy. Eles oferecem:

- Pool de proxy de alta qualidade: Acesso a um conjunto premium de proxies com excelente reputação e desempenho.

- Recuperação confiável de dados: Garantindo que suas solicitações não tenham taxa limitada, mantendo assim um acesso consistente aos dados necessários.

Aplicação de OneProxy em Web Scraping

Utilizar o OneProxy pode melhorar significativamente seus recursos de web scraping. Ao encaminhar suas solicitações por meio de vários proxies, você pode:

- Ignorar limite de taxa e CAPTCHAs: OneProxy pode ajudar a contornar medidas anti-raspagem comuns.

- Acesse dados da Web precisos e ilimitados: Com uma rede proxy robusta, o OneProxy garante acesso confiável e ininterrupto aos dados.

Ao combinar o poder do ChatGPT com o uso estratégico de ferramentas como OneProxy e aderir às melhores práticas em codificação e web scraping, você pode coletar de forma eficiente e eficaz os dados necessários de uma ampla variedade de fontes da web.

Conclusão: liberando o poder do ChatGPT em Web Scraping

Em resumo, o ChatGPT surge como uma ferramenta fundamental no domínio do web scraping, trazendo uma infinidade de oportunidades para o primeiro plano. Seus recursos de geração, refinamento e aprimoramento de código são indispensáveis para web scrapers novatos e experientes.

O papel do ChatGPT no web scraping não se limita apenas à geração de código; estende-se ao fornecimento de dicas esclarecedoras, ao manuseio de páginas da web complexas e até mesmo ao aconselhamento sobre as melhores práticas para uma raspagem eficiente. À medida que a tecnologia evolui, a contribuição do ChatGPT para simplificar e avançar nas tarefas de web scraping torna-se cada vez mais vital.

Isso marca uma nova era em que o web scraping, alimentado por ferramentas avançadas de IA como o ChatGPT, se torna mais acessível, eficiente e eficaz para uma ampla gama de usuários, desde amadores individuais até analistas de dados em grande escala.

Um brinde aos empreendimentos de raspagem bem-sucedidos e inovadores no futuro – Happy Scraping!