Node Unblocker, una versatile libreria Node JS costruita sul framework Express, è progettata principalmente per l'inoltro e la riscrittura di pagine Web remote. Questa libreria consente la creazione di un'istanza del server sul tuo computer locale che funge da proxy. Consente efficacemente agli utenti di aggirare le limitazioni geografiche e di altro tipo di accesso reindirizzando le richieste dal computer locale al server di destinazione previsto e viceversa.

Il processo di configurazione per Sblocco dei nodi è semplice e richiede solo poche righe di codice per essere avviato su quasi tutte le macchine. Questa semplicità si estende al suo funzionamento, dove migliora la funzionalità riscrivendo gli URL. Antepone agli URL il prefisso “/proxy/” prima del protocollo HTTP, una modifica che aiuta a superare le barriere della rete locale.

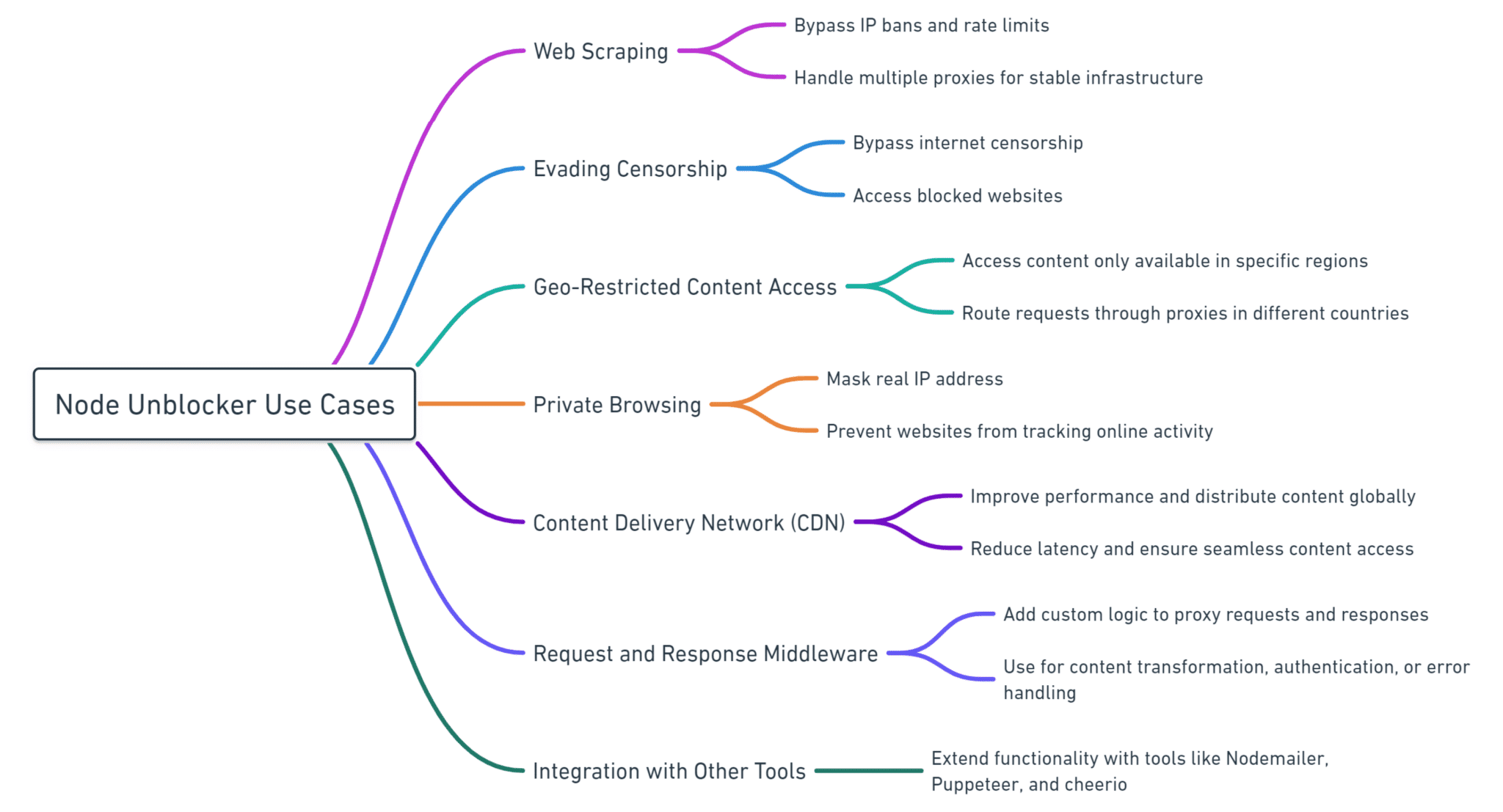

Node Unblocker è particolarmente utile per le attività di web scraping, offrendo una soluzione fattibile per coloro che utilizzano servizi cloud o macchine di terze parti. Configurando Node Unblocker su queste piattaforme, gli utenti possono stabilire un proxy affidabile per lo scraping dei dati.

Tuttavia, Node Unblocker ha i suoi limiti. Ha difficoltà con alcune pagine Web complesse, in particolare quelle su piattaforme di social media che utilizzano tecnologie come postMessage, che Node Unblocker non è in grado di elaborare. Allo stesso modo, i siti Web che utilizzano AJAX o richiedono l'autenticazione OAuth presentano sfide per questa libreria.

In termini di funzionamento, Node Unblocker funziona generando un server proxy web su una macchina locale. Elabora e inoltra le richieste HTTP tra i server di origine e di destinazione. Sebbene possa fungere da proxy web di base, Node Unblocker è arricchito da diverse funzionalità avanzate che estendono la sua utilità oltre il semplice inoltro di richieste.

Le funzionalità principali e le personalizzazioni disponibili tramite il middleware di Node Unblocker includono:

- Rimozione della politica di sicurezza dei contenuti (CSP).: questa funzionalità, sebbene potenzialmente rischiosa, consente l'esecuzione di script in linea e aiuta nella gestione dei contenuti caricati dinamicamente tramite JavaScript.

- Gestione dei cookie: L'utilizzo dei cookie può facilitare il mantenimento delle sessioni utente, la navigazione nei processi a più fasi e potenzialmente ridurre la probabilità di essere bloccati.

- Gestione dei reindirizzamenti: questa funzionalità garantisce che i reindirizzamenti vengano elaborati correttamente tramite il proxy, migliorando l'affidabilità.

- Personalizzazioni del middleware: queste regolazioni consentono agli utenti di alterare i comportamenti di richiesta e risposta, come la modifica delle intestazioni della richiesta, il che è particolarmente utile nel web scraping e in applicazioni simili.

Inoltre, Node Unblocker consente ampie modifiche alla configurazione tramite il suo file di installazione, comprese opzioni come il controllo dell'esecuzione di JavaScript tramite il proxy, che può essere disabilitato in base ai requisiti dell'utente. Queste ampie opzioni di personalizzazione rendono Node Unblocker uno strumento prezioso per coloro che hanno accesso a un ampio pool di proxy, offrendo una soluzione solida per complesse attività di web scraping e raccolta dati.

Configurazione essenziale per l'implementazione dello sblocco dei nodi

Per le persone che intraprendono la configurazione di Node Unblocker con una configurazione preliminare minima, alcuni prerequisiti sono essenziali per garantire un inizio senza intoppi.

Requisiti chiave

- Ambiente Node.js

L'installazione di Node.js è fondamentale in quanto fornisce l'ambiente runtime necessario per eseguire Node Unblocker. - Ambiente di sviluppo integrato (IDE)

La selezione di un IDE è fondamentale per lo sviluppo e la gestione del codice. Gli esempi includono Atom e Webstorm. Questa guida continuerà con Webstorm, sebbene i principi sottostanti siano applicabili a qualsiasi IDE. - Fornitore di servizi cloud

L'utilizzo di un fornitore di servizi cloud migliora l'efficacia di Node Unblocker consentendo operazioni tramite indirizzi IP esterni, ottimizzandolo così per il web scraping.

Installazione di Node.js e configurazione iniziale

Dopo aver configurato il tuo IDE, il passaggio successivo prevede l'inizializzazione di un progetto Node.js tramite il terminale con il seguente comando:

npm init -yQuesto comando semplifica la configurazione inserendo automaticamente i valori predefiniti per i metadati del progetto.

Dopo l'inizializzazione, il passaggio successivo consiste nell'installare i pacchetti essenziali:

npm install unblocker expressQuesti comandi aggiungono Unblocker ed Express al tuo progetto, facilitando la creazione di un server.

Incorporamento delle librerie necessarie

Inizia importando le librerie richieste nel file di progetto:

const express = require('express');

const Unblocker = require('unblocker');Utilizzando const garantisce che queste variabili rimangano costanti durante tutta l'applicazione.

Configurazione del proxy Web

Configura il server delle applicazioni e l'istanza di Unblocker con:

const app = express();

const unblocker = new Unblocker({prefix: '/proxy/'});

app.use(unblocker);Questa configurazione garantisce che tutte le richieste proxy utilizzino il prefisso "/proxy/", separandole dal traffico regolare.

Facoltativamente, definire una porta personalizzata:

const port = 3000;Avvio del server

Per attivare il tuo server:

app.listen(process.env.PORT || port || 8080).on('upgrade', unblocker.onUpgrade);

console.log("Node Unblocker Server Running On Port:", process.env.PORT || port || 8080);Questa configurazione garantisce che il server sia in ascolto su una porta specifica e gestisca gli aggiornamenti del protocollo necessari per determinati tipi di traffico di rete.

Test del server locale

È consigliabile testare il server localmente prima della distribuzione:

Passare alla directory del progetto e avviare il server:

cd X:\YOUR\PROJECT\FOLDER

node app.jsUtilizzando un browser o un cURL, verifica la funzionalità del server accedendo a:

http://localhost:8080/proxy/https://oneproxy.pro/Assicurarsi che venga utilizzato il numero di porta corretto per evitare problemi di connessione.

Distribuzione su un server remoto

Sebbene sia possibile la distribuzione locale, l'utilizzo di un server cloud consente di accedere in modo efficace ai contenuti con limitazioni geografiche.

Procedura di distribuzione del cloud

- Aggiorna il

package.jsonper adattarsi all'ambiente di distribuzione. - Scegli un fornitore di servizi cloud e configura una macchina virtuale.

- Tramite SSH o interfacce basate su browser, trasferisci i file di progetto sul server.

- Regola le impostazioni di ascolto del server per soddisfare le policy di rete, spesso necessarie sulle piattaforme cloud.

app.listen(process.env.PORT || port || 8080, '0.0.0.0').on('upgrade', unblocker.onUpgrade);- Installa Node.js sulla macchina cloud.

- Avvia l'applicazione:

node app.jsVerifica la funzionalità accedendo a:

VM_EXTERNAL_IP_ADDRESS:PORT/proxy/https://oneproxy.proRegola le impostazioni del firewall se si verificano problemi di connessione, assicurandoti che il traffico HTTP sia consentito attraverso la porta specificata. Questa configurazione completa garantisce che Node Unblocker sia pronto per robuste attività di web scraping e accesso ai contenuti.

Scalabilità delle operazioni di web scraping con Node Unblocker

Sfruttare Node Unblocker per i progetti iniziali

Node Unblocker funge da strumento efficace per le esigenze di web scraping di base ed è particolarmente utile per i progetti più piccoli. Utilizzando un fornitore di servizi cloud, puoi distribuire Node Unblocker per aggirare la censura di Internet, superare le restrizioni geografiche e accedere a un'ampia gamma di contenuti. Questa flessibilità lo rende adatto a singoli individui o piccoli team che stanno appena iniziando a esplorare le possibilità del web scraping.

Considerazioni sulla raschiatura a lungo termine e su larga scala

Sebbene Node Unblocker sia utile per applicazioni su scala ridotta, è importante riconoscere le limitazioni inerenti all'utilizzo di uno o pochi server proxy:

- Rischio di divieto IP: L'uso continuo di un unico indirizzo IP per lo scraping può portare a una rapida inclusione nella lista nera dei siti Web di destinazione.

- Scalabilità: Aumentare la scalabilità con il solo Node Unblocker può essere complicato se dipendente da un numero limitato di VM cloud.

Strategie per espandere le capacità dei proxy

Per progetti più estesi o richieste di dati più elevate, prendi in considerazione le seguenti strategie per migliorare l'efficienza dello scraping e ridurre il rischio di blocchi:

- Diversificare le fonti proxy:

- Istanze multiple di sblocco dei nodi: la distribuzione di più proxy su diverse VM cloud può aiutare a distribuire il carico e ridurre al minimo il rischio che un singolo IP venga bannato.

- Proxy residenziali: questi proxy utilizzano indirizzi IP assegnati a utenti residenziali e hanno meno probabilità di essere rilevati e bloccati rispetto agli IP dei datacenter.

- Investi in un servizio di proxy pool:

- Efficienza dei costi: i servizi proxy più grandi offrono spesso tariffe migliori per IP o per GB di dati, rendendoli più convenienti per operazioni su larga scala.

- Funzionalità avanzate: I servizi proxy professionali possono fornire funzionalità aggiuntive come la rotazione IP automatica, la selezione IP geografica mirata e funzionalità di instradamento del traffico più sofisticate.

- Conformità ai Termini del servizio:

- Assicurati sempre che le tue attività di scraping rispettino i termini di servizio sia dei siti Web di destinazione che del tuo fornitore di servizi cloud. Questa precauzione aiuta a evitare problemi legali e interruzioni del servizio.

Considerazioni future

Man mano che le tue esigenze di raschiatura crescono, valuta continuamente le prestazioni e il rapporto costo-efficacia dei tuoi strumenti. La transizione da una configurazione autogestita di Node Unblocker a un servizio proxy gestito potrebbe produrre vantaggi significativi in termini di scalabilità, affidabilità e costi di manutenzione.

Conclusione

Node Unblocker è un ottimo punto di partenza per il web scraping, soprattutto per i principianti e i progetti su piccola scala. Tuttavia, man mano che le tue esigenze si espandono, valuta la possibilità di passare a soluzioni più robuste come i pool di proxy commerciali per garantire operazioni di web scraping sostenibili ed efficienti.