ChatGPT OpenAI نشان دهنده یک جهش قابل توجه در فناوری هوش مصنوعی است. این ربات چت بسیار پیچیده که با مدل زبان GPT-3 تقویت شده است، اکنون برای مخاطبان جهانی قابل دسترسی است.

ChatGPT به عنوان یک ابزار مکالمه هوشمند متمایز است که در طیف گسترده ای از داده ها آموزش دیده است. این باعث میشود که آن را بهطور استثنایی سازگار کند و بتواند به چالشهای بیشماری در طیفی از زمینهها رسیدگی کند.

هدف این راهنما آموزش استفاده از ChatGPT برای ساخت اسکراپرهای وب پایتون موثر است. علاوه بر این، ما نکات و تکنیک های ضروری را برای اصلاح و ارتقای کالیبر برنامه نویسی اسکراپر شما ارائه خواهیم کرد.

بیایید کاوش در مورد استفاده از ChatGPT برای خراش دادن وب را آغاز کنیم و کاربردهای بالقوه و عملی آن را کشف کنیم.

پیاده سازی Web Scraping از طریق ChatGPT

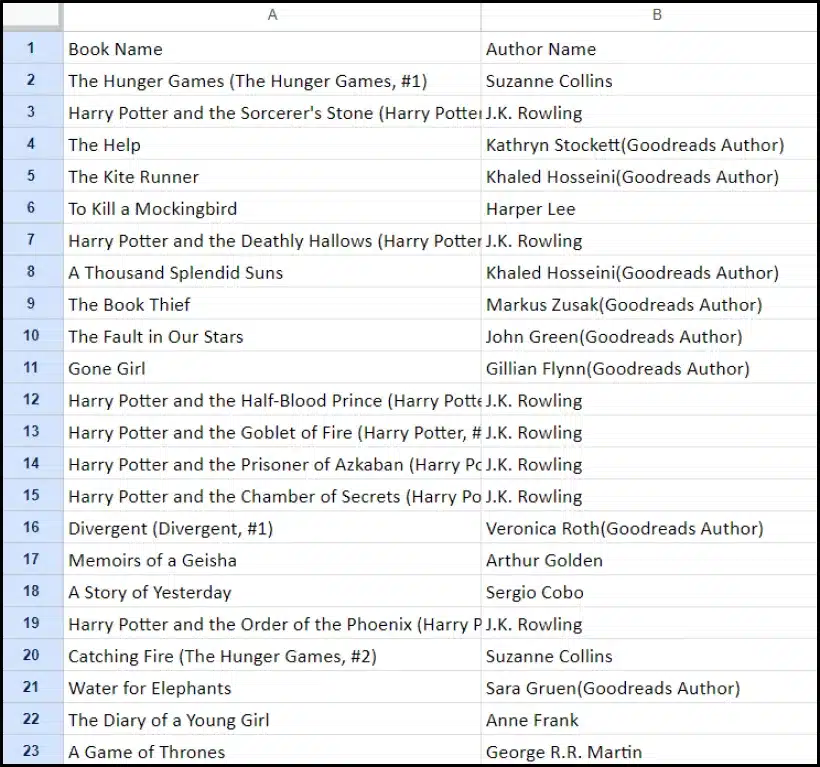

این آموزش شما را در فرآیند استخراج فهرستی از کتاب ها از سایت goodreads.com راهنمایی می کند. برای کمک به درک شما، یک نمایش بصری از طرح صفحه وب سایت ارائه خواهیم کرد.

در مرحله بعد، ما مراحل حیاتی لازم برای جمع آوری داده ها با استفاده از ChatGPT را به طور موثر بیان می کنیم.

راه اندازی یک حساب ChatGPT

فرآیند راه اندازی یک حساب ChatGPT ساده است. به صفحه ورود ChatGPT بروید و گزینه ثبت نام را انتخاب کنید. از طرف دیگر، برای راحتی بیشتر، می توانید با استفاده از حساب Google خود ثبت نام کنید.

پس از تکمیل ثبت نام، به رابط چت دسترسی خواهید داشت. شروع مکالمه به سادگی وارد کردن پرس و جو یا پیام خود در کادر متنی ارائه شده است.

ایجاد یک درخواست موثر برای ChatGPT

هنگامی که به دنبال کمک ChatGPT در کارهای برنامه نویسی مانند حذف وب هستید، وضوح و جزئیات در درخواست شما بسیار مهم است. زبان برنامه نویسی را به همراه هر ابزار یا کتابخانه لازم به صراحت بیان کنید. علاوه بر این، عناصر خاصی از صفحه وب را که قصد کار با آن را دارید به وضوح شناسایی کنید.

به همان اندازه مهم این است که نتیجه مورد نظر برنامه و هر استاندارد یا الزامات کدگذاری خاصی را که باید رعایت شود، مشخص کنید.

به عنوان مثال، این درخواست مثالی را در نظر بگیرید که درخواست توسعه یک اسکراپر وب پایتون با استفاده از کتابخانه BeautifulSoup را دارد.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.پس از این، یک قطعه کد مناسب باید توسط ChatGPT تولید شود.

ارزیابی کد تولید شده

هنگامی که ChatGPT کد را ارائه کرد، بررسی کامل آن بسیار مهم است. بررسی کنید که شامل کتابخانههای اضافی نیست و تأیید کنید که همه بستههای لازم برای عملکرد صحیح کد در دسترس هستند.

اگر با هر گونه مشکل یا مغایرت با کد مواجه شدید، دریغ نکنید که برای تنظیمات یا بازنویسی کامل در صورت لزوم با ChatGPT تماس بگیرید.

پیاده سازی Scraper شما

پس از بررسی، کد ارائه شده را کپی کرده و یک اجرای آزمایشی برای اطمینان از عملکرد مناسب آن انجام دهید. در اینجا مثالی از نحوه ظاهر کد وب scraper آورده شده است.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")خروجی نمونه داده های خراشیده شده در زیر آورده شده است.

بهبود پروژه اسکراپینگ وب خود با ChatGPT: تکنیک ها و ملاحظات پیشرفته

همانطور که در کد ارائه شده مشهود است، با توسعه وب اسکراپر پایتون با استفاده از BeautifulSoup، پیشرفت چشمگیری داشته اید. این اسکریپت یک نقطه شروع عالی برای جمع آوری کارآمد داده ها از صفحه وب Goodreads مشخص شده است. اکنون، اجازه دهید برخی از جنبه های پیشرفته را برای بهبود بیشتر پروژه خراش دادن وب خود بررسی کنیم.

بهینه سازی کد خود برای کارایی

کد کارآمد برای اسکرپینگ موفق وب، به ویژه برای کارهای در مقیاس بزرگ، حیاتی است. برای بهبود عملکرد اسکراپر خود، استراتژی های زیر را در نظر بگیرید:

- چارچوب ها و بسته های اهرمی: در مورد چارچوب ها و بسته هایی که می توانند اسکراپینگ وب را تسریع کنند به دنبال مشاوره باشید.

- استفاده از تکنیک های ذخیره سازی: برای ذخیره دادههای واکشی شده قبلی و کاهش تماسهای اضافی شبکه، حافظه پنهان را اجرا کنید.

- از پردازش همزمان یا موازی استفاده کنید: این رویکرد میتواند به طور قابل توجهی سرعت بازیابی دادهها را با انجام چندین کار به طور همزمان افزایش دهد.

- تماس های غیر ضروری شبکه را به حداقل برسانید: برای بهینهسازی استفاده از شبکه، فقط روی واکشی دادههای ضروری تمرکز کنید.

مدیریت محتوای وب پویا

بسیاری از وبسایتهای مدرن از تکنیکهای تولید محتوای پویا استفاده میکنند که اغلب به جاوا اسکریپت تکیه میکنند. در اینجا چند راه وجود دارد که ChatGPT می تواند به شما در پیمایش چنین پیچیدگی هایی کمک کند:

- از مرورگرهای Headless استفاده کنید: ChatGPT می تواند شما را در استفاده از مرورگرهای بدون سر برای خراش دادن محتوای پویا راهنمایی کند.

- خودکار کردن تعاملات کاربر: اقدامات شبیه سازی شده کاربر را می توان برای تعامل با صفحات وب که دارای رابط کاربری پیچیده هستند، خودکار کرد.

کد لینتینگ و ویرایش

حفظ کد تمیز و خوانا بسیار مهم است. ChatGPT می تواند به چندین روش کمک کند:

- پیشنهاد بهترین شیوه ها: ChatGPT می تواند استانداردها و شیوه های کدنویسی را برای افزایش خوانایی و کارایی توصیه کند.

- کد خود را پر کنید: برای پیشنهادات مربوط به مرتب کردن و بهینه سازی اسکریپت خود، از ChatGPT درخواست کنید تا "کد را پر کند".

غلبه بر محدودیت ها با خدمات پروکسی

در حالی که ChatGPT یک ابزار قدرتمند است، ضروری است که محدودیتها را هنگام جمعآوری دادههای وب از سایتها با اقدامات امنیتی سختگیرانه تأیید کنید. برای مقابله با چالشهایی مانند CAPTCHA و محدود کردن نرخ، استفاده از خدمات پراکسی مانند OneProxy را در نظر بگیرید. آنها ارائه می دهند:

- استخر پروکسی با کیفیت بالا: دسترسی به مجموعه ای از پراکسی ها با شهرت و عملکرد عالی.

- بازیابی اطلاعات قابل اعتماد: اطمینان حاصل کنید که درخواستهای شما با نرخ محدود نیستند، بنابراین دسترسی مداوم به دادههای مورد نیاز را حفظ میکنید.

کاربرد OneProxy در Web Scraping

استفاده از OneProxy می تواند به طور قابل توجهی قابلیت خراش وب شما را افزایش دهد. با مسیریابی درخواست های خود از طریق پروکسی های مختلف، می توانید:

- محدودیت نرخ دور زدن و CAPTCHA: OneProxy می تواند در دور زدن اقدامات رایج ضد خراشیدن کمک کند.

- دسترسی به داده های وب دقیق و نامحدود: OneProxy با یک شبکه پراکسی قوی، دسترسی مطمئن و بدون وقفه به داده ها را تضمین می کند.

با ترکیب قدرت ChatGPT با استفاده استراتژیک از ابزارهایی مانند OneProxy و پیروی از بهترین شیوه ها در کدنویسی و اسکرپینگ وب، می توانید داده های مورد نیاز خود را به طور موثر و موثر از طیف گسترده ای از منابع وب جمع آوری کنید.

نتیجه گیری: آزادسازی قدرت ChatGPT در اسکراپینگ وب

به طور خلاصه، ChatGPT به عنوان یک ابزار محوری در قلمرو scraping وب ظاهر می شود و فرصت های زیادی را به خط مقدم می آورد. قابلیتهای آن در تولید، پالایش و بهبود کد برای هر دو وباسکراپرهای تازه کار و باتجربه ضروری است.

نقش ChatGPT در اسکرپینگ وب فقط به تولید کد محدود نمی شود. این به ارائه نکات روشنگر، مدیریت صفحات وب پیچیده، و حتی مشاوره در مورد بهترین شیوه ها برای خراش دادن کارآمد گسترش می یابد. با پیشرفت فناوری، مشارکت ChatGPT در سادهسازی و پیشبرد وظایف اسکراپینگ وب به طور فزایندهای حیاتی میشود.

این نشاندهنده دوران جدیدی است که در آن اسکراپینگ وب، با ابزارهای پیشرفته هوش مصنوعی مانند ChatGPT، برای طیف گستردهای از کاربران، از افراد سرگرمکننده گرفته تا تحلیلگران داده در مقیاس بزرگ، در دسترستر، کارآمدتر و مؤثرتر میشود.

در اینجا به تلاش های موفق و نوآورانه خراش دادن در آینده می پردازیم - خراشیدن مبارک!