ChatGPT OpenAI mewakili lompatan signifikan dalam teknologi AI. Chatbot yang sangat canggih ini, didukung oleh model bahasa GPT-3, kini dapat diakses oleh khalayak global.

ChatGPT menonjol sebagai alat percakapan cerdas, yang telah dilatih tentang serangkaian data yang komprehensif. Hal ini menjadikannya sangat mudah beradaptasi, mampu mengatasi berbagai tantangan di berbagai bidang.

Panduan ini bertujuan untuk memberi petunjuk kepada Anda tentang cara memanfaatkan ChatGPT untuk membuat scraper web Python yang efektif. Selain itu, kami akan memberikan tip dan teknik penting untuk menyempurnakan dan meningkatkan kualitas pemrograman scraper Anda.

Mari kita mulai eksplorasi penggunaan ChatGPT untuk web scraping, mengungkap potensi dan aplikasi praktisnya.

Menerapkan Web Scraping melalui ChatGPT

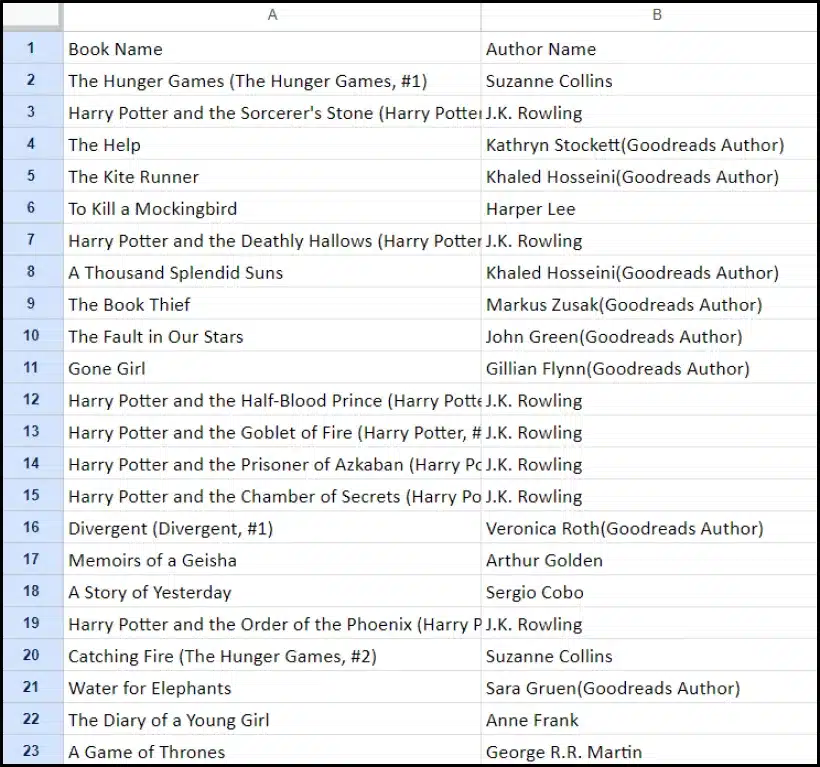

Tutorial ini akan memandu Anda melalui proses mengekstraksi daftar buku dari goodreads.com. Kami akan menyajikan representasi visual tata letak halaman situs web untuk membantu pemahaman Anda.

Selanjutnya, kami menguraikan langkah-langkah penting yang diperlukan untuk mengumpulkan data menggunakan ChatGPT secara efektif.

Menyiapkan Akun ChatGPT

Proses menyiapkan akun ChatGPT sangatlah mudah. Navigasikan ke Halaman Login ChatGPT dan pilih opsi pendaftaran. Alternatifnya, untuk menambah kenyamanan, Anda dapat memilih untuk mendaftar menggunakan akun Google Anda.

Setelah menyelesaikan pendaftaran, Anda akan mendapatkan akses ke antarmuka obrolan. Memulai percakapan semudah memasukkan pertanyaan atau pesan Anda di kotak teks yang disediakan.

Membuat Prompt yang Efektif untuk ChatGPT

Saat mencari bantuan ChatGPT dalam tugas pemrograman seperti web scraping, kejelasan dan detail dalam perintah Anda adalah yang terpenting. Nyatakan secara eksplisit bahasa pemrograman, beserta alat atau perpustakaan apa pun yang diperlukan. Selain itu, identifikasi dengan jelas elemen spesifik halaman web yang ingin Anda gunakan.

Yang tidak kalah pentingnya adalah menentukan hasil yang diinginkan dari program dan standar atau persyaratan pengkodean tertentu yang perlu dipatuhi.

Misalnya, pertimbangkan contoh permintaan ini yang meminta pengembangan web scraper Python menggunakan perpustakaan BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.Setelah ini, cuplikan kode yang sesuai harus dibuat oleh ChatGPT.

Mengevaluasi Kode yang Dihasilkan

Setelah ChatGPT memberikan kodenya, penting untuk meninjaunya secara menyeluruh. Verifikasi bahwa itu tidak menyertakan perpustakaan yang berlebihan dan konfirmasikan bahwa semua paket yang diperlukan tersedia agar kode dapat berfungsi dengan benar.

Jika Anda mengalami masalah atau perbedaan dengan kode, jangan ragu untuk menghubungi ChatGPT untuk melakukan penyesuaian atau penulisan ulang lengkap jika diperlukan.

Menerapkan Scraper Anda

Setelah meninjau, salin kode yang diberikan dan lakukan uji coba untuk memastikan fungsionalitasnya tepat. Berikut ini contoh tampilan kode web scraper.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")Contoh output dari data yang diambil diberikan di bawah ini.

Meningkatkan Proyek Scraping Web Anda dengan ChatGPT: Teknik dan Pertimbangan Tingkat Lanjut

Anda telah membuat kemajuan signifikan dengan mengembangkan web scraper Python menggunakan BeautifulSoup, seperti yang terlihat dalam kode yang disediakan. Skrip ini adalah titik awal yang sangat baik untuk mengumpulkan data secara efisien dari halaman web Goodreads yang ditentukan. Sekarang, mari selami beberapa aspek lanjutan untuk lebih menyempurnakan proyek web scraping Anda.

Mengoptimalkan Kode Anda untuk Efisiensi

Kode yang efisien sangat penting untuk keberhasilan web scraping, terutama untuk tugas berskala besar. Untuk meningkatkan kinerja scraper Anda, pertimbangkan strategi berikut:

- Kerangka Kerja dan Paket Leverage: Mintalah saran tentang kerangka kerja dan paket yang dapat mempercepat web scraping.

- Gunakan Teknik Caching: Terapkan caching untuk menyimpan data yang diambil sebelumnya, sehingga mengurangi panggilan jaringan yang berlebihan.

- Gunakan Pemrosesan Konkurensi atau Paralel: Pendekatan ini secara signifikan dapat mempercepat pengambilan data dengan menangani banyak tugas secara bersamaan.

- Minimalkan Panggilan Jaringan yang Tidak Perlu: Fokus pada pengambilan data penting saja untuk mengoptimalkan penggunaan jaringan.

Menangani Konten Web Dinamis

Banyak situs web modern menggunakan teknik pembuatan konten dinamis, seringkali mengandalkan JavaScript. Berikut beberapa cara ChatGPT dapat membantu Anda mengatasi kerumitan tersebut:

- Gunakan Browser Tanpa Kepala: ChatGPT dapat memandu Anda dalam menggunakan browser tanpa kepala untuk menyalin konten dinamis.

- Interaksi Pengguna Otomatis: Tindakan pengguna yang disimulasikan dapat diotomatisasi untuk berinteraksi dengan halaman web yang memiliki antarmuka pengguna yang kompleks.

Linting dan Pengeditan Kode

Menjaga kode tetap bersih dan mudah dibaca sangatlah penting. ChatGPT dapat membantu dalam beberapa cara:

- Sarankan Praktik Terbaik: ChatGPT dapat merekomendasikan standar dan praktik pengkodean untuk meningkatkan keterbacaan dan efisiensi.

- Lintasi Kode Anda: Minta ChatGPT untuk 'menyalin kode' untuk mendapatkan saran dalam merapikan dan mengoptimalkan skrip Anda.

Mengatasi Keterbatasan dengan Layanan Proxy

Meskipun ChatGPT adalah alat yang ampuh, penting untuk mengetahui keterbatasan saat mengambil data web dari situs dengan langkah keamanan yang ketat. Untuk mengatasi tantangan seperti CAPTCHA dan pembatasan tarif, pertimbangkan untuk menggunakan layanan proxy seperti OneProxy. Mereka menawarkan:

- Kumpulan Proksi Berkualitas Tinggi: Akses ke kumpulan proxy premium dengan reputasi dan kinerja luar biasa.

- Pengambilan Data yang Andal: Memastikan permintaan Anda tidak dibatasi tarifnya, sehingga menjaga akses yang konsisten ke data yang diperlukan.

Penerapan OneProxy di Web Scraping

Memanfaatkan OneProxy dapat meningkatkan kemampuan web scraping Anda secara signifikan. Dengan merutekan permintaan Anda melalui berbagai proxy, Anda dapat:

- Pembatasan Tingkat Bypass dan CAPTCHA: OneProxy dapat membantu menghindari tindakan anti-goresan yang umum.

- Akses Data Web yang Akurat dan Tidak Terbatas: Dengan jaringan proxy yang kuat, OneProxy memastikan akses data yang andal dan tidak terputus.

Dengan menggabungkan kekuatan ChatGPT dengan penggunaan alat yang strategis seperti OneProxy dan mengikuti praktik terbaik dalam coding dan web scraping, Anda dapat mengumpulkan data yang Anda perlukan dari berbagai sumber web secara efisien dan efektif.

Kesimpulan: Melepaskan Kekuatan ChatGPT di Web Scraping

Singkatnya, ChatGPT muncul sebagai alat penting dalam bidang web scraping, membawa banyak peluang ke permukaan. Kemampuannya dalam menghasilkan, menyempurnakan, dan menyempurnakan kode sangat diperlukan baik bagi pengikis web pemula maupun berpengalaman.

Peran ChatGPT dalam web scraping tidak hanya terbatas pada pembuatan kode; hal ini mencakup pemberian tips yang berwawasan luas, menangani halaman web yang rumit, dan bahkan memberikan saran tentang praktik terbaik untuk pengikisan yang efisien. Seiring berkembangnya teknologi, kontribusi ChatGPT untuk menyederhanakan dan memajukan tugas web scraping menjadi semakin penting.

Hal ini menandai era baru di mana web scraping, yang didukung oleh alat AI canggih seperti ChatGPT, menjadi lebih mudah diakses, efisien, dan efektif untuk berbagai pengguna, mulai dari penghobi individu hingga analis data berskala besar.

Ini untuk upaya pengikisan yang sukses dan inovatif di masa depan – Selamat Mengikis!