ChatGPT d'OpenAI représente une avancée significative dans la technologie de l'IA. Ce chatbot hautement sophistiqué, alimenté par le modèle linguistique GPT-3, est désormais accessible à un public mondial.

ChatGPT se distingue comme un outil conversationnel intelligent, ayant été formé sur une gamme complète de données. Cela le rend exceptionnellement adaptable, capable de relever une myriade de défis dans un large éventail de domaines.

Ce guide vise à vous expliquer comment utiliser ChatGPT pour créer des scrapers Web Python efficaces. De plus, nous fournirons des conseils et des techniques essentiels pour affiner et élever le calibre de la programmation de votre scraper.

Commençons par explorer l'utilisation de ChatGPT pour le web scraping, en découvrant ses applications potentielles et pratiques.

Implémentation du Web Scraping via ChatGPT

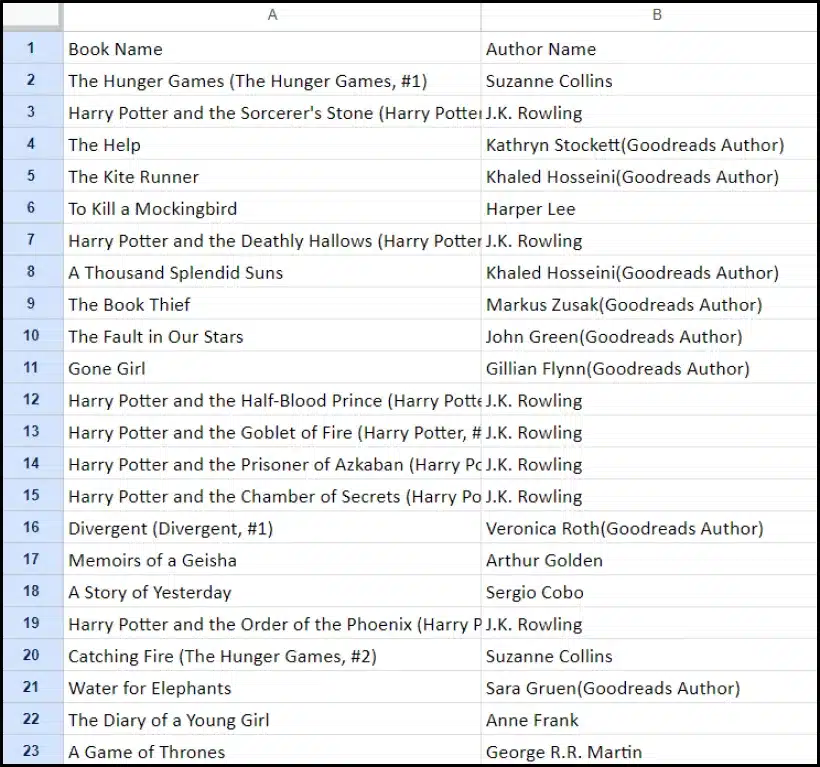

Ce didacticiel vous guidera tout au long du processus d'extraction d'une liste de livres de goodreads.com. Nous présenterons une représentation visuelle de la mise en page du site Web pour vous aider à comprendre.

Ensuite, nous décrivons les étapes critiques nécessaires pour récolter des données en utilisant efficacement ChatGPT.

Créer un compte ChatGPT

Le processus de création d'un compte ChatGPT est simple. Accédez à la page de connexion ChatGPT et sélectionnez l'option d'inscription. Alternativement, pour plus de commodité, vous pouvez choisir de vous inscrire en utilisant votre compte Google.

Une fois l’inscription terminée, vous aurez accès à l’interface de chat. Initier une conversation est aussi simple que de saisir votre requête ou votre message dans la zone de texte fournie.

Créer une invite efficace pour ChatGPT

Lorsque vous demandez l'aide de ChatGPT pour des tâches de programmation telles que le web scraping, la clarté et les détails de votre invite sont primordiaux. Indiquez explicitement le langage de programmation, ainsi que tous les outils ou bibliothèques nécessaires. De plus, identifiez clairement les éléments spécifiques de la page Web avec laquelle vous avez l’intention de travailler.

Il est tout aussi important de spécifier le résultat souhaité du programme et toutes les normes ou exigences de codage spécifiques qui doivent être respectées.

Par exemple, considérons cet exemple d'invite demandant le développement d'un grattoir Web Python utilisant la bibliothèque BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.Suite à cela, un extrait de code approprié doit être généré par ChatGPT.

Évaluation du code généré

Une fois que ChatGPT a fourni le code, il est crucial de l'examiner attentivement. Vérifiez qu'il n'inclut pas de bibliothèques superflues et confirmez que tous les packages nécessaires sont disponibles pour que le code fonctionne correctement.

Si vous rencontrez des problèmes ou des divergences avec le code, n'hésitez pas à contacter ChatGPT pour des ajustements ou une réécriture complète si nécessaire.

Implémentation de votre grattoir

Après examen, copiez le code fourni et effectuez un essai pour garantir son bon fonctionnement. Voici un exemple de ce à quoi pourrait ressembler le code du web scraper.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")L’exemple de sortie des données récupérées est donné ci-dessous.

Améliorer votre projet de Web Scraping avec ChatGPT : techniques avancées et considérations

Vous avez fait des progrès significatifs en développant un grattoir Web Python à l'aide de BeautifulSoup, comme le montre le code fourni. Ce script est un excellent point de départ pour récolter efficacement les données de la page Web Goodreads spécifiée. Examinons maintenant quelques aspects avancés pour améliorer davantage votre projet de web scraping.

Optimiser votre code pour plus d'efficacité

Un code efficace est essentiel pour un web scraping réussi, en particulier pour les tâches à grande échelle. Pour améliorer les performances de votre grattoir, envisagez les stratégies suivantes :

- Tirer parti des frameworks et des packages : Demandez conseil sur les frameworks et les packages qui peuvent accélérer le web scraping.

- Utiliser des techniques de mise en cache : Implémentez la mise en cache pour sauvegarder les données précédemment récupérées, réduisant ainsi les appels réseau redondants.

- Utiliser la concurrence ou le traitement parallèle : Cette approche peut accélérer considérablement la récupération des données en gérant plusieurs tâches simultanément.

- Minimisez les appels réseau inutiles : Concentrez-vous sur la récupération uniquement des données essentielles pour optimiser l’utilisation du réseau.

Gestion du contenu Web dynamique

De nombreux sites Web modernes utilisent des techniques de génération de contenu dynamique, s'appuyant souvent sur JavaScript. Voici quelques façons dont ChatGPT peut vous aider à naviguer dans de telles complexités :

- Utilisez des navigateurs sans tête : ChatGPT peut vous guider dans l'utilisation de navigateurs sans tête pour récupérer du contenu dynamique.

- Automatisez les interactions utilisateur : Les actions utilisateur simulées peuvent être automatisées pour interagir avec des pages Web dotées d'interfaces utilisateur complexes.

Linting et édition de code

Il est crucial de maintenir un code propre et lisible. ChatGPT peut vous aider de plusieurs manières :

- Suggérer les meilleures pratiques : ChatGPT peut recommander des normes et des pratiques de codage pour améliorer la lisibilité et l'efficacité.

- Lint votre code : Demandez à ChatGPT de « pelucher le code » pour obtenir des suggestions sur le rangement et l'optimisation de votre script.

Surmonter les limites avec les services proxy

Bien que ChatGPT soit un outil puissant, il est essentiel de reconnaître les limites lors de la récupération de données Web à partir de sites soumis à des mesures de sécurité strictes. Pour relever des défis tels que les CAPTCHA et la limitation de débit, envisagez d'utiliser des services proxy tels que OneProxy. Ils offrent:

- Pool proxy de haute qualité : Accès à un pool premium de proxys avec une excellente réputation et performance.

- Récupération de données fiable : Assurez-vous que vos demandes ne sont pas limitées en débit, maintenant ainsi un accès cohérent aux données requises.

Application de OneProxy dans le Web Scraping

L'utilisation de OneProxy peut améliorer considérablement vos capacités de scraping Web. En acheminant vos requêtes via différents proxys, vous pouvez :

- Contourner la limitation du débit et les CAPTCHA : Le OneProxy peut aider à contourner les mesures anti-grattage courantes.

- Accédez à des données Web précises et illimitées : Avec un réseau proxy robuste, OneProxy garantit un accès aux données fiable et ininterrompu.

En combinant la puissance de ChatGPT avec l'utilisation stratégique d'outils tels que OneProxy et en adhérant aux meilleures pratiques en matière de codage et de web scraping, vous pouvez collecter de manière efficace et efficiente les données dont vous avez besoin à partir d'un large éventail de sources Web.

Conclusion : Libérer la puissance de ChatGPT dans le Web Scraping

En résumé, ChatGPT apparaît comme un outil essentiel dans le domaine du web scraping, mettant au premier plan une multitude d’opportunités. Ses capacités à générer, affiner et améliorer le code sont indispensables aux web scrapers débutants et chevronnés.

Le rôle de ChatGPT dans le web scraping ne se limite pas à la génération de code ; cela s'étend à la fourniture de conseils judicieux, à la gestion de pages Web complexes et même à des conseils sur les meilleures pratiques pour un scraping efficace. À mesure que la technologie évolue, la contribution de ChatGPT à la simplification et à l'avancement des tâches de web scraping devient de plus en plus vitale.

Cela marque une nouvelle ère dans laquelle le web scraping, alimenté par des outils d'IA avancés comme ChatGPT, devient plus accessible, efficace et efficient pour un large éventail d'utilisateurs, des amateurs individuels aux analystes de données à grande échelle.

À vous les efforts de scraping réussis et innovants à l'avenir – Happy Scraping !