ChatGPT de OpenAI representa un salto significativo en la tecnología de IA. Este chatbot altamente sofisticado, impulsado por el modelo de lenguaje GPT-3, ahora es accesible para una audiencia global.

ChatGPT se destaca como una herramienta conversacional inteligente, ya que ha sido entrenada con una amplia gama de datos. Esto lo hace excepcionalmente adaptable y capaz de abordar innumerables desafíos en un espectro de campos.

Esta guía tiene como objetivo instruirle sobre cómo utilizar ChatGPT para construir raspadores web Python eficaces. Además, le brindaremos consejos y técnicas esenciales para refinar y elevar el calibre de la programación de su raspador.

Embarquémonos en una exploración del uso de ChatGPT para web scraping, descubriendo sus aplicaciones potenciales y prácticas.

Implementación de Web Scraping a través de ChatGPT

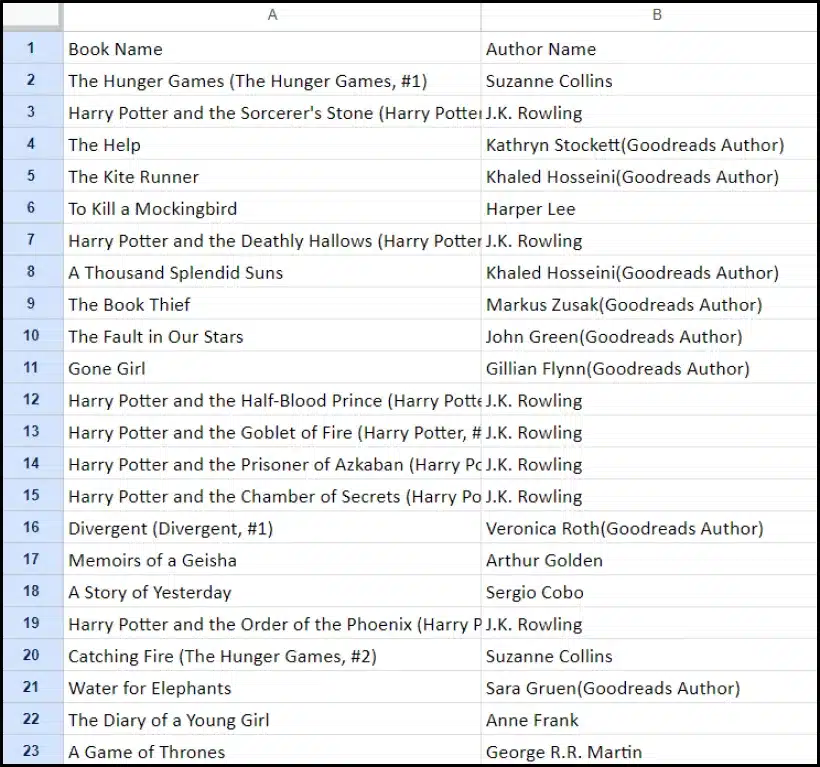

Este tutorial lo guiará a través del proceso de extracción de una lista de libros de goodreads.com. Presentaremos una representación visual del diseño de la página del sitio web para ayudarle a comprenderlo.

A continuación, describimos los pasos críticos necesarios para recopilar datos utilizando ChatGPT de manera efectiva.

Configurar una cuenta ChatGPT

El proceso de configuración de una cuenta ChatGPT es sencillo. Navegue a la página de inicio de sesión de ChatGPT y seleccione la opción de registro. Alternativamente, para mayor comodidad, puede optar por registrarse utilizando su cuenta de Google.

Al completar el registro, obtendrá acceso a la interfaz de chat. Iniciar una conversación es tan simple como ingresar su consulta o mensaje en el cuadro de texto provisto.

Elaboración de un mensaje eficaz para ChatGPT

Cuando busque la ayuda de ChatGPT en tareas de programación como el web scraping, la claridad y el detalle en su mensaje son primordiales. Indique explícitamente el lenguaje de programación, junto con las herramientas o bibliotecas necesarias. Además, identifique claramente los elementos específicos de la página web con la que desea trabajar.

Igualmente importante es especificar el resultado deseado del programa y cualquier estándar o requisito de codificación específico que deba cumplirse.

Por ejemplo, considere este mensaje ejemplar que solicita el desarrollo de un raspador web de Python utilizando la biblioteca BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.Después de esto, ChatGPT debe generar un fragmento de código adecuado.

Evaluación del código generado

Una vez que ChatGPT proporciona el código, es fundamental revisarlo detenidamente. Verifique que no incluya bibliotecas superfluas y confirme que todos los paquetes necesarios estén disponibles para que el código funcione correctamente.

Si encuentra algún problema o discrepancia con el código, no dude en comunicarse con ChatGPT para realizar ajustes o una reescritura completa si es necesario.

Implementando su raspador

Después de revisar, copie el código proporcionado y realice una prueba para garantizar su funcionalidad adecuada. A continuación se muestra un ejemplo de cómo podría verse el código del raspador web.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")El resultado de muestra de los datos extraídos se proporciona a continuación.

Mejora de su proyecto de Web Scraping con ChatGPT: técnicas avanzadas y consideraciones

Ha logrado un progreso significativo al desarrollar un raspador web de Python utilizando BeautifulSoup, como se evidencia en el código proporcionado. Este script es un excelente punto de partida para recopilar datos de manera eficiente de la página web de Goodreads especificada. Ahora, profundicemos en algunos aspectos avanzados para mejorar aún más su proyecto de web scraping.

Optimización de su código para lograr eficiencia

El código eficiente es vital para el web scraping exitoso, particularmente para tareas a gran escala. Para mejorar el rendimiento de su raspador, considere las siguientes estrategias:

- Aproveche los marcos y paquetes: Busque asesoramiento sobre marcos y paquetes que puedan acelerar el web scraping.

- Utilice técnicas de almacenamiento en caché: Implemente el almacenamiento en caché para guardar datos obtenidos previamente, reduciendo las llamadas de red redundantes.

- Emplear procesamiento concurrente o paralelo: Este enfoque puede acelerar significativamente la recuperación de datos al manejar múltiples tareas simultáneamente.

- Minimice las llamadas de red innecesarias: Concéntrese en obtener solo los datos esenciales para optimizar el uso de la red.

Manejo de contenido web dinámico

Muchos sitios web modernos utilizan técnicas de generación de contenido dinámico, a menudo basándose en JavaScript. A continuación se muestran algunas formas en que ChatGPT puede ayudarlo a superar estas complejidades:

- Utilice navegadores sin cabeza: ChatGPT puede guiarlo en el uso de navegadores sin cabeza para extraer contenido dinámico.

- Automatizar las interacciones del usuario: Las acciones de usuario simuladas se pueden automatizar para interactuar con páginas web que tienen interfaces de usuario complejas.

Edición y edición de código

Mantener un código limpio y legible es fundamental. ChatGPT puede ayudar de varias maneras:

- Sugerir mejores prácticas: ChatGPT puede recomendar estándares y prácticas de codificación para mejorar la legibilidad y la eficiencia.

- Elimina tu código: Solicite a ChatGPT que "limpie el código" para obtener sugerencias sobre cómo ordenar y optimizar su secuencia de comandos.

Superar las limitaciones con los servicios de proxy

Si bien ChatGPT es una herramienta poderosa, es esencial reconocer las limitaciones al extraer datos web de sitios con estrictas medidas de seguridad. Para abordar desafíos como CAPTCHA y limitación de velocidad, considere utilizar servicios de proxy como OneProxy. Ellos ofrecen:

- Grupo de proxy de alta calidad: Acceso a un grupo premium de proxies con excelente reputación y rendimiento.

- Recuperación de datos confiable: Garantizar que sus solicitudes no tengan una tarifa limitada, manteniendo así un acceso constante a los datos requeridos.

Aplicación de OneProxy en Web Scraping

El uso de OneProxy puede mejorar significativamente sus capacidades de web scraping. Al enrutar sus solicitudes a través de varios servidores proxy, puede:

- Omitir limitación de velocidad y CAPTCHA: OneProxy puede ayudar a eludir las medidas anti-scraping comunes.

- Acceda a datos web precisos e ilimitados: Con una sólida red de proxy, OneProxy garantiza un acceso a datos confiable e ininterrumpido.

Al combinar el poder de ChatGPT con el uso estratégico de herramientas como OneProxy y seguir las mejores prácticas en codificación y web scraping, puede recopilar de manera eficiente y efectiva los datos que necesita de una amplia gama de fuentes web.

Conclusión: Liberar el poder de ChatGPT en Web Scraping

En resumen, ChatGPT emerge como una herramienta fundamental en el ámbito del web scraping, aportando una multitud de oportunidades a la vanguardia. Sus capacidades para generar, refinar y mejorar código son indispensables tanto para los web scrapers principiantes como para los experimentados.

El papel de ChatGPT en el web scraping no se limita sólo a la generación de código; se extiende a brindar consejos interesantes, manejar páginas web complejas e incluso asesorar sobre las mejores prácticas para un scraping eficiente. A medida que la tecnología evoluciona, la contribución de ChatGPT para simplificar y mejorar las tareas de web scraping se vuelve cada vez más vital.

Esto marca una nueva era en la que el web scraping, impulsado por herramientas avanzadas de inteligencia artificial como ChatGPT, se vuelve más accesible, eficiente y eficaz para una amplia gama de usuarios, desde aficionados individuales hasta analistas de datos a gran escala.

Por los esfuerzos de scraping exitosos e innovadores en el futuro: ¡Feliz Scraping!