يمثل ChatGPT من OpenAI قفزة كبيرة في تكنولوجيا الذكاء الاصطناعي. إن برنامج الدردشة الآلي المتطور للغاية هذا، والذي يغذيه نموذج اللغة GPT-3، أصبح الآن في متناول الجمهور العالمي.

تبرز ChatGPT كأداة محادثة ذكية، حيث تم تدريبها على مجموعة شاملة من البيانات. وهذا يجعلها قابلة للتكيف بشكل استثنائي، وقادرة على مواجهة تحديات لا تعد ولا تحصى عبر مجموعة واسعة من المجالات.

يهدف هذا الدليل إلى إرشادك حول كيفية استخدام ChatGPT لإنشاء كاشطات ويب Python فعالة. بالإضافة إلى ذلك، سنقدم النصائح والتقنيات الأساسية لتحسين ورفع مستوى برمجة أداة الكشط لديك.

دعونا نشرع في استكشاف استخدام ChatGPT لتجميع الويب، والكشف عن تطبيقاته المحتملة والعملية.

تنفيذ تجريف الويب عبر ChatGPT

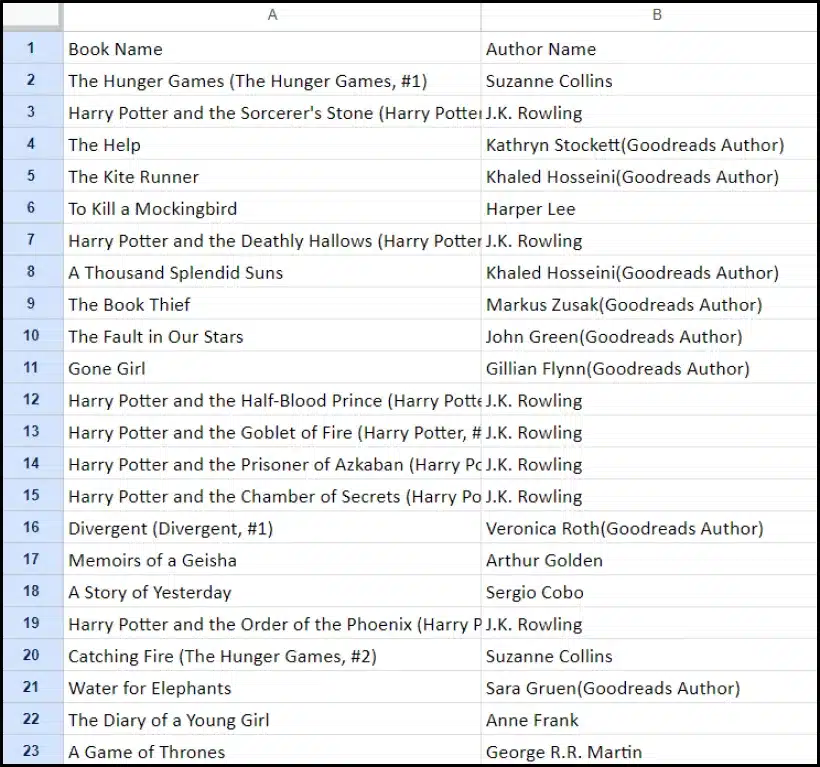

سيرشدك هذا البرنامج التعليمي خلال عملية استخراج قائمة الكتب من موقع goodreads.com. سنقدم تمثيلاً مرئيًا لتخطيط صفحة موقع الويب لمساعدتك على الفهم.

بعد ذلك، سنحدد الخطوات الحاسمة اللازمة لجمع البيانات باستخدام ChatGPT بشكل فعال.

إعداد حساب ChatGPT

عملية إعداد حساب ChatGPT واضحة ومباشرة. انتقل إلى صفحة تسجيل الدخول إلى ChatGPT وحدد خيار التسجيل. وبدلاً من ذلك، ولمزيد من الراحة، يمكنك اختيار الاشتراك باستخدام حساب Google الخاص بك.

عند الانتهاء من التسجيل، سوف تتمكن من الوصول إلى واجهة الدردشة. يعد بدء المحادثة أمرًا بسيطًا مثل إدخال استعلامك أو رسالتك في مربع النص المقدم.

صياغة مطالبة فعالة لـ ChatGPT

عند طلب مساعدة ChatGPT في مهام البرمجة مثل استخراج البيانات من الويب، فإن الوضوح والتفاصيل في مطالبتك أمر بالغ الأهمية. اذكر لغة البرمجة بوضوح، بالإضافة إلى أي أدوات أو مكتبات ضرورية. بالإضافة إلى ذلك، حدد بوضوح عناصر محددة في صفحة الويب التي تنوي العمل بها.

ومن المهم بنفس القدر تحديد النتيجة المرجوة من البرنامج وأي معايير أو متطلبات ترميز محددة يجب الالتزام بها.

على سبيل المثال، خذ بعين الاعتبار هذه المطالبة المثالية التي تطلب تطوير أداة استخراج بيانات ويب Python باستخدام مكتبة BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.بعد ذلك، يجب إنشاء مقتطف رمز مناسب بواسطة ChatGPT.

تقييم الكود الذي تم إنشاؤه

بمجرد أن يوفر ChatGPT الكود، فمن الضروري مراجعته بدقة. تأكد من أنه لا يتضمن مكتبات غير ضرورية وتأكد من توفر جميع الحزم الضرورية لكي يعمل الكود بشكل صحيح.

إذا واجهت أي مشكلات أو تناقضات في الكود، فلا تتردد في التواصل مع ChatGPT لإجراء التعديلات أو إعادة الكتابة بالكامل إذا لزم الأمر.

تنفيذ المكشطة الخاصة بك

بعد المراجعة، انسخ الكود المقدم وقم بإجراء التشغيل التجريبي للتأكد من تشغيله بشكل صحيح. فيما يلي مثال لكيفية ظهور كود استخراج الويب.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")ويرد أدناه نموذج إخراج البيانات المحذوفة.

تعزيز مشروع تجريف الويب الخاص بك باستخدام ChatGPT: تقنيات واعتبارات متقدمة

لقد أحرزت تقدمًا كبيرًا من خلال تطوير أداة استخراج بيانات الويب Python باستخدام BeautifulSoup، كما هو واضح في الكود المقدم. يعد هذا البرنامج النصي نقطة بداية ممتازة لجمع البيانات بكفاءة من صفحة ويب Goodreads المحددة. الآن، دعنا نتعمق في بعض الجوانب المتقدمة لتعزيز مشروع تجريف الويب الخاص بك بشكل أكبر.

تحسين التعليمات البرمجية الخاصة بك لتحقيق الكفاءة

تعد التعليمات البرمجية الفعالة أمرًا حيويًا لنجاح عملية تجريف الويب، خاصة بالنسبة للمهام واسعة النطاق. لتحسين أداء مكشطة الخاص بك، ضع في اعتبارك الاستراتيجيات التالية:

- الاستفادة من الأطر والحزم: اطلب المشورة بشأن الأطر والحزم التي يمكنها تسريع عملية تجريف الويب.

- الاستفادة من تقنيات التخزين المؤقت: قم بتنفيذ التخزين المؤقت لحفظ البيانات التي تم جلبها مسبقًا، مما يقلل من مكالمات الشبكة المتكررة.

- توظيف التزامن أو المعالجة المتوازية: يمكن لهذا الأسلوب تسريع عملية استرجاع البيانات بشكل كبير من خلال التعامل مع مهام متعددة في وقت واحد.

- تقليل مكالمات الشبكة غير الضرورية: ركز على جلب البيانات الأساسية فقط لتحسين استخدام الشبكة.

التعامل مع محتوى الويب الديناميكي

تستخدم العديد من مواقع الويب الحديثة تقنيات إنشاء المحتوى الديناميكي، وغالبًا ما تعتمد على JavaScript. فيما يلي بعض الطرق التي يمكن أن يساعدك بها ChatGPT في التغلب على مثل هذه التعقيدات:

- استخدم المتصفحات بدون رأس: بإمكان ChatGPT إرشادك لاستخدام المتصفحات بدون رأس لاستخراج المحتوى الديناميكي.

- أتمتة تفاعلات المستخدم: يمكن أتمتة إجراءات المستخدم المحاكاة للتفاعل مع صفحات الويب التي تحتوي على واجهات مستخدم معقدة.

فحص الكود وتحريره

يعد الحفاظ على التعليمات البرمجية النظيفة والقابلة للقراءة أمرًا بالغ الأهمية. يمكن لـ ChatGPT المساعدة بعدة طرق:

- اقترح أفضل الممارسات: يمكن لـ ChatGPT أن يوصي بمعايير وممارسات الترميز لتحسين سهولة القراءة والكفاءة.

- لينت التعليمات البرمجية الخاصة بك: اطلب من ChatGPT "فحص الكود" للحصول على اقتراحات حول ترتيب البرنامج النصي وتحسينه.

التغلب على القيود مع خدمات الوكيل

على الرغم من أن ChatGPT أداة قوية، فمن الضروري الاعتراف بالقيود عند استخراج بيانات الويب من المواقع ذات الإجراءات الأمنية الصارمة. لمواجهة تحديات مثل اختبار CAPTCHA وتحديد المعدل، فكر في استخدام خدمات الوكيل مثل OneProxy. يقدمون:

- تجمع وكيل عالي الجودة: الوصول إلى مجموعة متميزة من الوكلاء ذوي السمعة والأداء الممتازين.

- استرجاع البيانات بشكل موثوق: التأكد من أن طلباتك ليست محدودة السعر، وبالتالي الحفاظ على الوصول المستمر إلى البيانات المطلوبة.

تطبيق OneProxy في تجريف الويب

يمكن أن يؤدي استخدام OneProxy إلى تحسين قدرات تجريف الويب لديك بشكل كبير. من خلال توجيه طلباتك عبر وكلاء مختلفين، يمكنك:

- تجاوز معدل الحد وCAPTCHA: يمكن أن يساعد OneProxy في التحايل على إجراءات مكافحة التجريف الشائعة.

- الوصول إلى بيانات الويب الدقيقة وغير المحدودة: بفضل شبكة وكيل قوية، يضمن OneProxy وصولاً موثوقًا وغير متقطع إلى البيانات.

من خلال الجمع بين قوة ChatGPT والاستخدام الاستراتيجي لأدوات مثل OneProxy والالتزام بأفضل الممارسات في البرمجة وتجميع الويب، يمكنك جمع البيانات التي تحتاجها بكفاءة وفعالية من مجموعة واسعة من مصادر الويب.

الخلاصة: إطلاق العنان لقوة ChatGPT في تجريف الويب

باختصار، يظهر ChatGPT كأداة محورية في مجال استخراج الويب، مما يوفر العديد من الفرص في المقدمة. تعد قدراته في إنشاء التعليمات البرمجية وتحسينها وتحسينها أمرًا لا غنى عنه لكل من كاشطات الويب المبتدئين والمتمرسين.

لا يقتصر دور ChatGPT في استخراج البيانات من الويب على إنشاء التعليمات البرمجية فحسب؛ ويمتد الأمر ليشمل تقديم نصائح ثاقبة، والتعامل مع صفحات الويب المعقدة، وحتى تقديم المشورة بشأن أفضل الممارسات للتجميع الفعال. مع تطور التكنولوجيا، أصبحت مساهمة ChatGPT في تبسيط مهام استخراج البيانات من الويب وتطويرها أمرًا حيويًا بشكل متزايد.

يمثل هذا حقبة جديدة حيث يصبح استخراج الويب، المدعوم بأدوات الذكاء الاصطناعي المتقدمة مثل ChatGPT، أكثر سهولة وكفاءة وفعالية لمجموعة واسعة من المستخدمين، بدءًا من الهواة الأفراد وحتى محللي البيانات على نطاق واسع.

إليكم مساعي الكشط الناجحة والمبتكرة في المستقبل - القشط السعيد!