ChatGPT от OpenAI представляет собой значительный скачок в технологии искусственного интеллекта. Этот сложный чат-бот, работающий на языковой модели GPT-3, теперь доступен глобальной аудитории.

ChatGPT выделяется как интеллектуальный диалоговый инструмент, прошедший обучение на широком спектре данных. Это делает его исключительно адаптируемым и способным решать множество задач в самых разных областях.

Цель этого руководства — научить вас использовать ChatGPT для создания эффективных парсеров веб-страниц Python. Кроме того, мы предоставим важные советы и методы, которые помогут усовершенствовать и повысить качество программирования вашего парсера.

Давайте приступим к исследованию использования ChatGPT для парсинга веб-страниц, раскрывая его потенциал и практические применения.

Реализация парсинга веб-страниц через ChatGPT

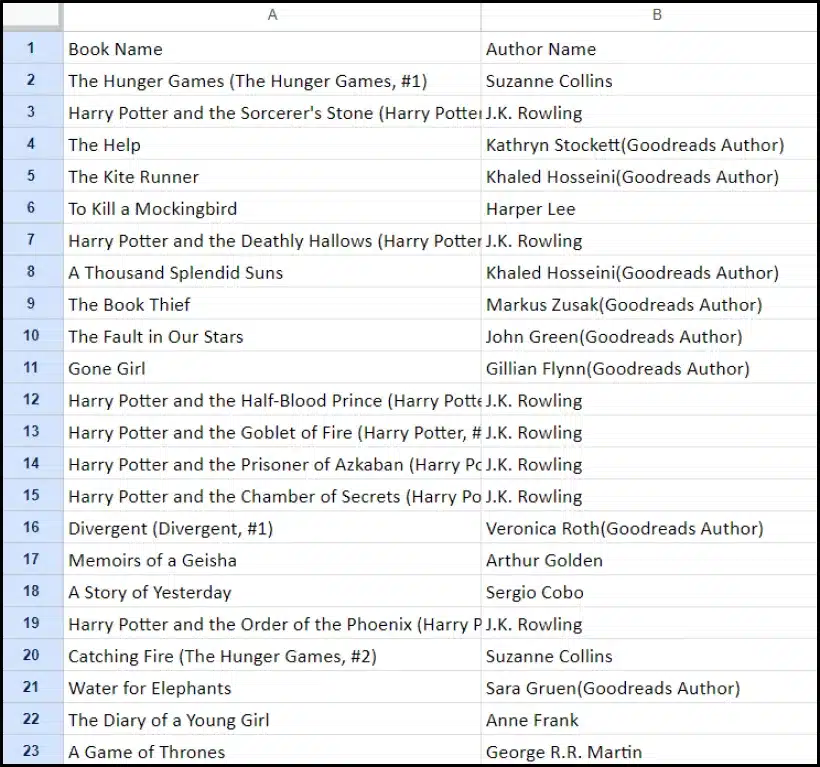

Это руководство проведет вас через процесс извлечения списка книг с сайта Goodreads.com. Мы представим визуальное представление макета страницы веб-сайта, чтобы помочь вам понять.

Далее мы обрисуем важные шаги, необходимые для эффективного сбора данных с помощью ChatGPT.

Настройка учетной записи ChatGPT

Процесс настройки учетной записи ChatGPT прост. Перейдите на страницу входа в ChatGPT и выберите вариант регистрации. Кроме того, для дополнительного удобства вы можете зарегистрироваться, используя свою учетную запись Google.

После завершения регистрации вы получите доступ к интерфейсу чата. Начать разговор так же просто, как ввести свой запрос или сообщение в предоставленное текстовое поле.

Создание эффективного приглашения для ChatGPT

При обращении за помощью к ChatGPT в таких задачах программирования, как парсинг веб-страниц, ясность и детализация подсказок имеют первостепенное значение. Явно укажите язык программирования, а также все необходимые инструменты и библиотеки. Кроме того, четко определите конкретные элементы веб-страницы, с которой вы собираетесь работать.

Не менее важно указать желаемый результат программы и любые конкретные стандарты или требования кодирования, которые необходимо соблюдать.

Например, рассмотрим этот пример запроса на разработку веб-скрейпера Python с использованием библиотеки BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.После этого ChatGPT должен сгенерировать подходящий фрагмент кода.

Оценка сгенерированного кода

После того как ChatGPT предоставит код, крайне важно тщательно его просмотреть. Убедитесь, что он не содержит лишних библиотек, и убедитесь, что все необходимые пакеты доступны для правильной работы кода.

Если у вас возникнут какие-либо проблемы или несоответствия с кодом, не стесняйтесь обращаться в ChatGPT за корректировками или полной переработкой, если это необходимо.

Реализация вашего парсера

После проверки скопируйте предоставленный код и проведите пробный запуск, чтобы убедиться в его правильной работе. Вот пример того, как может выглядеть код веб-скребка.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")Пример вывода очищенных данных приведен ниже.

Улучшение вашего проекта парсинга веб-страниц с помощью ChatGPT: продвинутые методы и соображения

Вы добились значительного прогресса, разработав веб-скребок Python с помощью BeautifulSoup, как видно из предоставленного кода. Этот сценарий является отличной отправной точкой для эффективного сбора данных с указанной веб-страницы Goodreads. Теперь давайте углубимся в некоторые дополнительные аспекты для дальнейшего улучшения вашего проекта по парсингу веб-страниц.

Оптимизация вашего кода для повышения эффективности

Эффективный код жизненно важен для успешного парсинга веб-страниц, особенно для крупномасштабных задач. Чтобы повысить производительность вашего парсера, рассмотрите следующие стратегии:

- Используйте фреймворки и пакеты: Обратитесь за советом по платформам и пакетам, которые могут ускорить парсинг веб-страниц.

- Используйте методы кэширования: Внедрите кэширование для сохранения ранее полученных данных, сокращая количество избыточных сетевых вызовов.

- Используйте параллельную обработку или параллельную обработку: Этот подход может значительно ускорить поиск данных за счет одновременной обработки нескольких задач.

- Минимизируйте ненужные сетевые вызовы: Сосредоточьтесь на получении только необходимых данных для оптимизации использования сети.

Обработка динамического веб-контента

Многие современные веб-сайты используют методы динамической генерации контента, часто опираясь на JavaScript. Вот несколько способов, которыми ChatGPT может помочь вам справиться с такими сложностями:

- Используйте безголовые браузеры: ChatGPT может помочь вам использовать автономные браузеры для очистки динамического контента.

- Автоматизация взаимодействия с пользователем: Имитированные действия пользователя могут быть автоматизированы для взаимодействия с веб-страницами со сложным пользовательским интерфейсом.

Линтинг и редактирование кода

Поддержание чистого и читаемого кода имеет решающее значение. ChatGPT может помочь несколькими способами:

- Предложите лучшие практики: ChatGPT может рекомендовать стандарты и методы кодирования для повышения читаемости и эффективности.

- Линтуйте свой код: Попросите ChatGPT «проверить код» и получить предложения по приведению в порядок и оптимизации вашего скрипта.

Преодоление ограничений с помощью прокси-сервисов

Хотя ChatGPT — мощный инструмент, важно учитывать ограничения при сборе веб-данных с сайтов со строгими мерами безопасности. Чтобы решить такие проблемы, как CAPTCHA и ограничение скорости, рассмотрите возможность использования прокси-сервисов, таких как OneProxy. Они предлагают:

- Качественный пул прокси: Доступ к премиальному пулу прокси с отличной репутацией и производительностью.

- Надежный поиск данных: Убедитесь, что ваши запросы не ограничены по скорости, что обеспечивает постоянный доступ к необходимым данным.

Применение OneProxy в веб-скрапинге

Использование OneProxy может значительно расширить ваши возможности парсинга веб-страниц. Направляя запросы через различные прокси, вы можете:

- Обход ограничения скорости и CAPTCHA: OneProxy может помочь обойти распространенные меры защиты от взлома.

- Доступ к точным и неограниченным веб-данным: Благодаря надежной прокси-сети OneProxy обеспечивает надежный и бесперебойный доступ к данным.

Объединив мощь ChatGPT со стратегическим использованием таких инструментов, как OneProxy, и придерживаясь лучших практик в кодировании и очистке веб-страниц, вы можете эффективно и действенно собирать необходимые вам данные из широкого спектра веб-источников.

Заключение: раскрытие возможностей ChatGPT при парсинге веб-страниц

Подводя итог, ChatGPT становится ключевым инструментом в сфере парсинга веб-страниц, открывая множество возможностей. Его возможности по созданию, уточнению и улучшению кода незаменимы как для новичков, так и для опытных парсеров.

Роль ChatGPT в парсинге веб-страниц не ограничивается только генерацией кода; он распространяется на предоставление полезных советов, обработку сложных веб-страниц и даже рекомендации по передовым методам эффективного парсинга. По мере развития технологий вклад ChatGPT в упрощение и улучшение задач парсинга веб-страниц становится все более важным.

Это знаменует собой новую эру, когда парсинг веб-страниц, основанный на передовых инструментах искусственного интеллекта, таких как ChatGPT, становится более доступным, эффективным и действенным для широкого круга пользователей, от отдельных любителей до крупных аналитиков данных.

За успешные и инновационные начинания в области парсинга в будущем – счастливого парсинга!