ChatGPT OpenAI mewakili lonjakan ketara dalam teknologi AI. Chatbot yang sangat canggih ini, didorong oleh model bahasa GPT-3, kini boleh diakses oleh khalayak global.

ChatGPT menonjol sebagai alat perbualan pintar, setelah dilatih mengenai rangkaian data yang komprehensif. Ini menjadikannya sangat mudah disesuaikan, mampu menangani pelbagai cabaran merentasi spektrum bidang.

Panduan ini bertujuan untuk mengarahkan anda menggunakan ChatGPT untuk membina pengikis web Python yang berkesan. Selain itu, kami akan memberikan petua dan teknik penting untuk memperhalusi dan meningkatkan kaliber pengaturcaraan pengikis anda.

Mari kita mulakan penerokaan menggunakan ChatGPT untuk mengikis web, mendedahkan potensi dan aplikasi praktikalnya.

Melaksanakan Web Scraping melalui ChatGPT

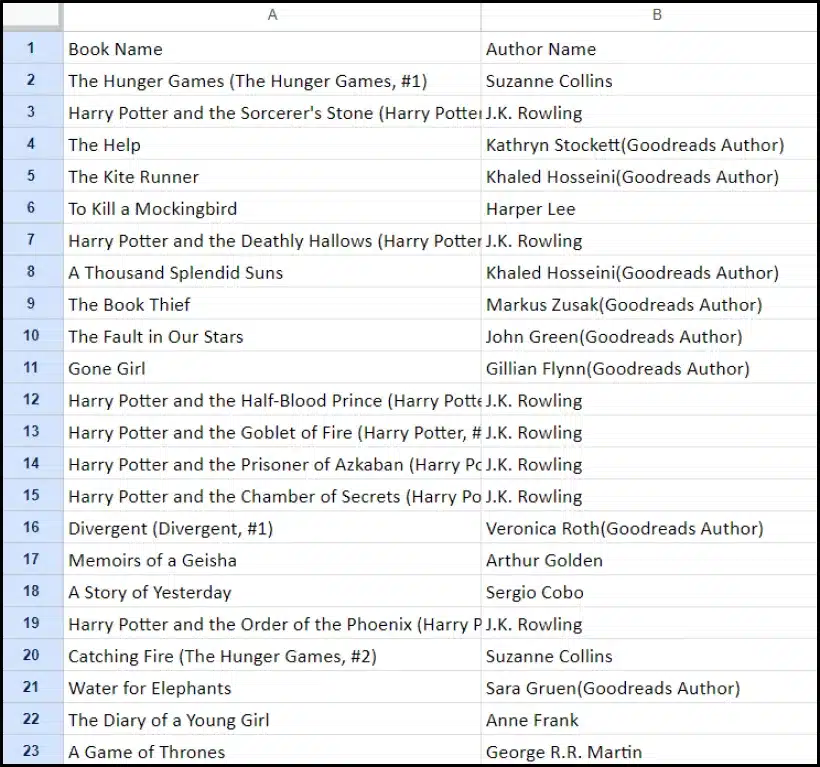

Tutorial ini akan membimbing anda melalui proses mengekstrak senarai buku daripada goodreads.com. Kami akan membentangkan gambaran visual reka letak halaman tapak web untuk membantu pemahaman anda.

Seterusnya, kami menggariskan langkah-langkah kritikal yang diperlukan untuk menuai data menggunakan ChatGPT dengan berkesan.

Menyediakan Akaun ChatGPT

Proses menyediakan akaun ChatGPT adalah mudah. Navigasi ke Halaman Log Masuk ChatGPT dan pilih pilihan pendaftaran. Sebagai alternatif, untuk kemudahan tambahan, anda boleh memilih untuk mendaftar menggunakan akaun Google anda.

Setelah melengkapkan pendaftaran, anda akan mendapat akses kepada antara muka sembang. Memulakan perbualan adalah semudah memasukkan pertanyaan atau mesej anda dalam kotak teks yang disediakan.

Mencipta Gesaan Berkesan untuk ChatGPT

Apabila mendapatkan bantuan ChatGPT dalam tugas pengaturcaraan seperti mengikis web, kejelasan dan perincian dalam gesaan anda adalah yang terpenting. Nyatakan secara eksplisit bahasa pengaturcaraan, bersama-sama dengan sebarang alat atau perpustakaan yang diperlukan. Selain itu, kenal pasti dengan jelas elemen khusus halaman web yang anda ingin bekerjasama.

Sama pentingnya ialah untuk menentukan hasil program yang dikehendaki dan sebarang piawaian atau keperluan pengekodan khusus yang perlu dipatuhi.

Sebagai contoh, pertimbangkan gesaan teladan ini yang meminta pembangunan pengikis web Python menggunakan perpustakaan BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.Berikutan ini, coretan kod yang sesuai harus dihasilkan oleh ChatGPT.

Menilai Kod Dihasilkan

Sebaik sahaja ChatGPT menyediakan kod, adalah penting untuk menyemaknya dengan teliti. Sahkan bahawa ia tidak termasuk perpustakaan yang berlebihan dan sahkan bahawa semua pakej yang diperlukan tersedia untuk kod berfungsi dengan betul.

Jika anda menghadapi sebarang isu atau percanggahan dengan kod, jangan teragak-agak untuk menghubungi ChatGPT untuk pelarasan atau penulisan semula lengkap jika perlu.

Melaksanakan Pengikis Anda

Selepas menyemak, salin kod yang disediakan dan jalankan percubaan untuk memastikan kefungsian yang betul. Berikut ialah contoh bagaimana kod pengikis web mungkin kelihatan.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")Output sampel data yang dikikis diberikan di bawah.

Meningkatkan Projek Mengikis Web Anda dengan ChatGPT: Teknik dan Pertimbangan Lanjutan

Anda telah mencapai kemajuan yang ketara dengan membangunkan pengikis web Python menggunakan BeautifulSoup, seperti yang ditunjukkan dalam kod yang disediakan. Skrip ini merupakan titik permulaan yang sangat baik untuk mengumpulkan data dengan cekap daripada halaman web Goodreads yang ditentukan. Sekarang, mari kita mendalami beberapa aspek lanjutan untuk meningkatkan lagi projek mengikis web anda.

Mengoptimumkan Kod Anda untuk Kecekapan

Kod yang cekap adalah penting untuk pengikisan web yang berjaya, terutamanya untuk tugasan berskala besar. Untuk meningkatkan prestasi pengikis anda, pertimbangkan strategi berikut:

- Rangka Kerja dan Pakej Leverage: Dapatkan nasihat tentang rangka kerja dan pakej yang boleh mempercepatkan pengikisan web.

- Gunakan Teknik Caching: Laksanakan caching untuk menyimpan data yang diambil sebelum ini, mengurangkan panggilan rangkaian yang berlebihan.

- Gunakan Concurrency atau Pemprosesan Selari: Pendekatan ini boleh mempercepatkan pengambilan data dengan ketara dengan mengendalikan pelbagai tugas secara serentak.

- Minimumkan Panggilan Rangkaian yang Tidak Diperlukan: Fokus pada mengambil hanya data penting untuk mengoptimumkan penggunaan rangkaian.

Mengendalikan Kandungan Web Dinamik

Banyak tapak web moden menggunakan teknik penjanaan kandungan dinamik, selalunya bergantung pada JavaScript. Berikut ialah beberapa cara ChatGPT boleh membantu anda dalam menavigasi kerumitan sedemikian:

- Gunakan Pelayar Tanpa Kepala: ChatGPT boleh membimbing anda menggunakan penyemak imbas tanpa kepala untuk mengikis kandungan dinamik.

- Automatikkan Interaksi Pengguna: Tindakan pengguna simulasi boleh diautomasikan untuk berinteraksi dengan halaman web yang mempunyai antara muka pengguna yang kompleks.

Penyuntingan Kod dan Penyuntingan

Mengekalkan kod yang bersih dan boleh dibaca adalah penting. ChatGPT boleh membantu dalam beberapa cara:

- Cadangkan Amalan Terbaik: ChatGPT boleh mengesyorkan piawaian dan amalan pengekodan untuk meningkatkan kebolehbacaan dan kecekapan.

- Selaraskan Kod Anda: Minta ChatGPT untuk 'membuka kod' untuk cadangan mengemas dan mengoptimumkan skrip anda.

Mengatasi Had dengan Perkhidmatan Proksi

Walaupun ChatGPT ialah alat yang berkuasa, adalah penting untuk mengakui batasan apabila mengikis data web daripada tapak dengan langkah keselamatan yang ketat. Untuk menangani cabaran seperti CAPTCHA dan pengehadan kadar, pertimbangkan untuk menggunakan perkhidmatan proksi seperti OneProxy. Mereka menawarkan:

- Kolam Proksi Berkualiti Tinggi: Akses kepada kumpulan proksi premium dengan reputasi dan prestasi cemerlang.

- Pendapatan Data Boleh Dipercayai: Memastikan permintaan anda tidak terhad pada kadar, dengan itu mengekalkan akses yang konsisten kepada data yang diperlukan.

Aplikasi OneProxy dalam Pengikisan Web

Menggunakan OneProxy boleh meningkatkan keupayaan mengikis web anda dengan ketara. Dengan menghalakan permintaan anda melalui pelbagai proksi, anda boleh:

- Had Kadar Pintasan dan CAPTCHA: OneProxy boleh membantu dalam mengelakkan langkah anti-mengikis biasa.

- Akses Data Web Tepat dan Tanpa Had: Dengan rangkaian proksi yang mantap, OneProxy memastikan akses data yang boleh dipercayai dan tidak terganggu.

Dengan menggabungkan kuasa ChatGPT dengan penggunaan alat strategik seperti OneProxy dan mematuhi amalan terbaik dalam pengekodan dan mengikis web, anda boleh mengumpul data yang anda perlukan dengan cekap dan berkesan daripada pelbagai sumber web.

Kesimpulan: Melancarkan Kuasa ChatGPT dalam Pengikisan Web

Ringkasnya, ChatGPT muncul sebagai alat penting dalam bidang mengikis web, membawa banyak peluang ke hadapan. Keupayaannya dalam menjana, memperhalusi dan mempertingkatkan kod amat diperlukan untuk pengikis web yang baru dan berpengalaman.

Peranan ChatGPT dalam mengikis web bukan hanya terhad kepada penjanaan kod; ia meluas kepada menyediakan petua yang bernas, mengendalikan halaman web yang kompleks, malah memberi nasihat tentang amalan terbaik untuk mengikis yang cekap. Apabila teknologi berkembang, sumbangan ChatGPT untuk memudahkan dan memajukan tugas mengikis web menjadi semakin penting.

Ini menandakan era baharu di mana pengikisan web, dikuasakan oleh alatan AI lanjutan seperti ChatGPT, menjadi lebih mudah diakses, cekap dan berkesan untuk pelbagai pengguna, daripada penggemar individu kepada penganalisis data berskala besar.

Berikut adalah usaha mengikis yang berjaya dan inovatif pada masa hadapan – Selamat Mengikis!