OpenAI의 ChatGPT는 AI 기술의 획기적인 도약을 나타냅니다. GPT-3 언어 모델을 기반으로 하는 이 매우 정교한 챗봇은 이제 전 세계 사용자가 액세스할 수 있습니다.

ChatGPT는 광범위한 데이터에 대한 교육을 받은 지능형 대화 도구로 두각을 나타냅니다. 이로 인해 탁월한 적응력을 갖고 다양한 분야에 걸쳐 수많은 과제를 해결할 수 있습니다.

이 가이드의 목적은 ChatGPT를 활용하여 효과적인 Python 웹 스크레이퍼를 구성하는 방법을 안내하는 것입니다. 또한, 우리는 스크레이퍼 프로그래밍의 수준을 개선하고 향상시키기 위한 필수 팁과 기술을 제공할 것입니다.

웹 스크래핑을 위해 ChatGPT를 사용하는 방법에 대한 탐색을 시작하여 잠재력과 실제 응용 프로그램을 찾아보겠습니다.

ChatGPT를 통해 웹 스크래핑 구현

이 튜토리얼은 goodreads.com에서 도서 목록을 추출하는 과정을 안내합니다. 귀하의 이해를 돕기 위해 웹사이트의 페이지 레이아웃을 시각적으로 보여드리겠습니다.

다음으로 ChatGPT를 효과적으로 사용하여 데이터를 수집하는 데 필요한 중요한 단계를 간략하게 설명합니다.

ChatGPT 계정 설정

ChatGPT 계정을 설정하는 과정은 간단합니다. ChatGPT 로그인 페이지로 이동하여 가입 옵션을 선택하세요. 또는 추가 편의를 위해 Google 계정을 사용하여 가입하도록 선택할 수도 있습니다.

등록을 완료하면 채팅 인터페이스에 액세스할 수 있습니다. 대화를 시작하는 것은 제공된 텍스트 상자에 쿼리나 메시지를 입력하는 것만큼 간단합니다.

ChatGPT에 대한 효과적인 프롬프트 작성

웹 스크래핑과 같은 프로그래밍 작업에서 ChatGPT의 도움을 구할 때 프롬프트의 명확성과 세부사항이 가장 중요합니다. 필요한 도구나 라이브러리와 함께 프로그래밍 언어를 명시적으로 명시합니다. 또한 작업하려는 웹 페이지의 특정 요소를 명확하게 식별하십시오.

마찬가지로 중요한 것은 프로그램의 원하는 결과와 준수해야 하는 특정 코딩 표준 또는 요구 사항을 지정하는 것입니다.

예를 들어 BeautifulSoup 라이브러리를 활용하는 Python 웹 스크레이퍼 개발을 요청하는 예시적인 프롬프트를 생각해 보세요.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.그런 다음 ChatGPT에서 적합한 코드 조각을 생성해야 합니다.

생성된 코드 평가

ChatGPT가 코드를 제공한 후에는 철저하게 검토하는 것이 중요합니다. 불필요한 라이브러리가 포함되어 있지 않은지 확인하고 코드가 올바르게 작동하는 데 필요한 모든 패키지를 사용할 수 있는지 확인하세요.

코드에 문제나 불일치가 있는 경우 주저하지 말고 ChatGPT에 문의하여 조정을 요청하거나 필요한 경우 전체 재작성을 요청하세요.

스크레이퍼 구현

검토 후 제공된 코드를 복사하고 시험 실행을 수행하여 제대로 작동하는지 확인하세요. 다음은 웹 스크래퍼 코드가 어떻게 보이는지에 대한 예입니다.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

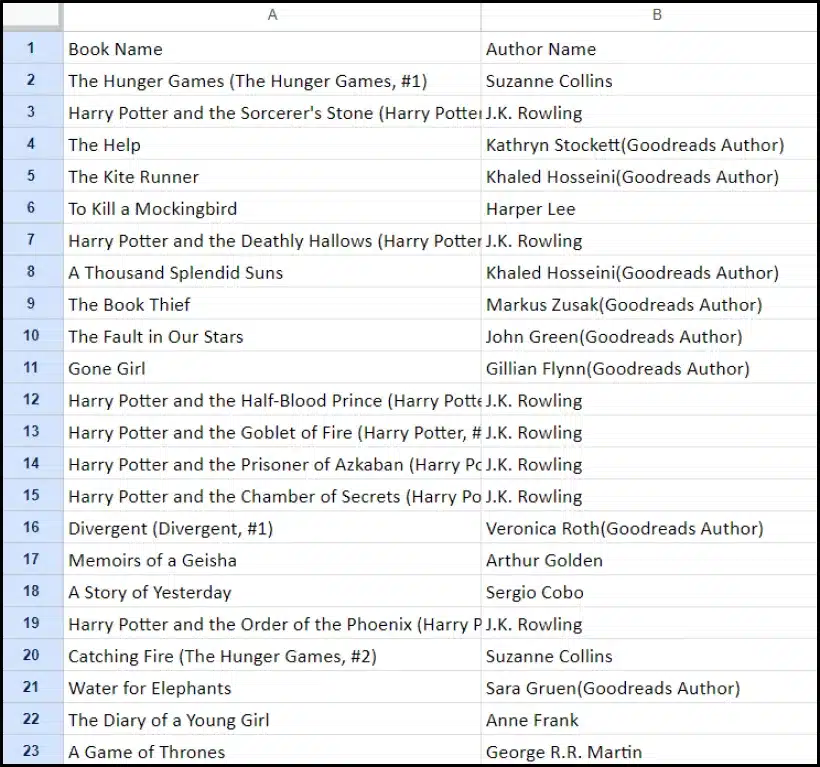

print(f"Failed to retrieve data. Status code: {response.status_code}")스크랩된 데이터의 샘플 출력은 다음과 같습니다.

ChatGPT로 웹 스크래핑 프로젝트 향상: 고급 기술 및 고려 사항

제공된 코드에서 알 수 있듯이 BeautifulSoup을 사용하여 Python 웹 스크래퍼를 개발하여 상당한 진전을 이루었습니다. 이 스크립트는 지정된 Goodreads 웹페이지에서 데이터를 효율적으로 수집하기 위한 훌륭한 시작점입니다. 이제 웹 스크래핑 프로젝트를 더욱 향상시키기 위한 몇 가지 고급 측면을 살펴보겠습니다.

효율성을 위한 코드 최적화

특히 대규모 작업의 경우 성공적인 웹 스크래핑을 위해서는 효율적인 코드가 필수적입니다. 스크레이퍼의 성능을 향상하려면 다음 전략을 고려하십시오.

- 프레임워크 및 패키지 활용: 웹 스크래핑을 가속화할 수 있는 프레임워크 및 패키지에 대한 조언을 구하세요.

- 캐싱 기술 활용: 이전에 가져온 데이터를 저장하는 캐싱을 구현하여 중복 네트워크 호출을 줄입니다.

- 동시성 또는 병렬 처리를 사용합니다. 이 접근 방식은 여러 작업을 동시에 처리하여 데이터 검색 속도를 크게 높일 수 있습니다.

- 불필요한 네트워크 호출 최소화: 네트워크 사용을 최적화하기 위해 필수 데이터만 가져오는 데 집중하세요.

동적 웹 콘텐츠 처리

많은 현대 웹사이트는 종종 JavaScript에 의존하는 동적 콘텐츠 생성 기술을 사용합니다. ChatGPT가 이러한 복잡성을 해결하는 데 도움을 줄 수 있는 몇 가지 방법은 다음과 같습니다.

- 헤드리스 브라우저 활용: ChatGPT는 동적 콘텐츠를 스크랩하기 위해 헤드리스 브라우저를 사용하는 방법을 안내할 수 있습니다.

- 사용자 상호 작용 자동화: 시뮬레이션된 사용자 작업을 자동화하여 복잡한 사용자 인터페이스가 있는 웹 페이지와 상호 작용할 수 있습니다.

코드 린팅 및 편집

깨끗하고 읽기 쉬운 코드를 유지하는 것이 중요합니다. ChatGPT는 여러 가지 방법으로 도움을 줄 수 있습니다.

- 모범 사례 제안: ChatGPT는 가독성과 효율성을 높이기 위해 코딩 표준과 관행을 권장할 수 있습니다.

- 코드를 린트하세요: 스크립트 정리 및 최적화에 대한 제안을 보려면 ChatGPT에 '코드 린트'를 요청하세요.

프록시 서비스로 한계 극복

ChatGPT는 강력한 도구이지만 엄격한 보안 조치가 적용되는 사이트에서 웹 데이터를 스크랩할 때 제한 사항을 인정하는 것이 중요합니다. CAPTCHA 및 속도 제한과 같은 문제를 해결하려면 OneProxy와 같은 프록시 서비스를 사용하는 것이 좋습니다. 그들은 다음을 제공합니다:

- 고품질 프록시 풀: 탁월한 평판과 성능을 갖춘 프리미엄 프록시 풀에 액세스하세요.

- 안정적인 데이터 검색: 요청의 속도가 제한되지 않도록 하여 필요한 데이터에 대한 일관된 액세스를 유지합니다.

웹 스크래핑에 OneProxy 적용

OneProxy를 활용하면 웹 스크래핑 기능을 크게 향상시킬 수 있습니다. 다양한 프록시를 통해 요청을 라우팅하면 다음을 수행할 수 있습니다.

- 우회 속도 제한 및 CAPTCHA: OneProxy는 일반적인 스크래핑 방지 조치를 우회하는 데 도움이 될 수 있습니다.

- 정확하고 무제한의 웹 데이터에 액세스: 강력한 프록시 네트워크를 통해 OneProxy는 안정적이고 중단 없는 데이터 액세스를 보장합니다.

ChatGPT의 강력한 기능과 OneProxy와 같은 도구의 전략적 사용을 결합하고 코딩 및 웹 스크래핑의 모범 사례를 준수함으로써 광범위한 웹 소스에서 필요한 데이터를 효율적이고 효과적으로 수집할 수 있습니다.

결론: 웹 스크래핑에서 ChatGPT의 힘 활용

요약하면, ChatGPT는 웹 스크래핑 영역에서 중추적인 도구로 등장하여 수많은 기회를 최전선으로 가져옵니다. 코드 생성, 개선 및 향상 기능은 초보자와 노련한 웹 스크레이퍼 모두에게 필수적입니다.

웹 스크래핑에서 ChatGPT의 역할은 코드 생성에만 국한되지 않습니다. 이는 통찰력 있는 팁 제공, 복잡한 웹 페이지 처리, 효율적인 스크래핑을 위한 모범 사례 조언까지 확장됩니다. 기술이 발전함에 따라 웹 스크래핑 작업을 단순화하고 발전시키는 ChatGPT의 기여가 점점 더 중요해지고 있습니다.

이는 ChatGPT와 같은 고급 AI 도구로 구동되는 웹 스크래핑이 개인 애호가부터 대규모 데이터 분석가에 이르기까지 광범위한 사용자에게 더욱 접근하기 쉽고 효율적이며 효과적인 새로운 시대를 의미합니다.

미래의 성공적이고 혁신적인 스크래핑 노력은 다음과 같습니다 – Happy Scraping!