OpenAI の ChatGPT は、AI テクノロジーの大きな飛躍を表しています。GPT-3 言語モデルを搭載したこの非常に洗練されたチャットボットは、現在、世界中のユーザーが利用できます。

ChatGPT は、包括的なデータに基づいてトレーニングされた、インテリジェントな会話ツールとして際立っています。これにより、非常に適応性が高く、さまざまな分野にわたる無数の課題に対応できます。

このガイドは、ChatGPT を使用して効果的な Python Web スクレイパーを構築する方法を説明することを目的としています。さらに、スクレイパーのプログラミングの品質を洗練および向上させるための重要なヒントとテクニックも提供します。

ChatGPT を Web スクレイピングに使用する方法を探り、その可能性と実用的なアプリケーションを明らかにしましょう。

ChatGPT による Web スクレイピングの実装

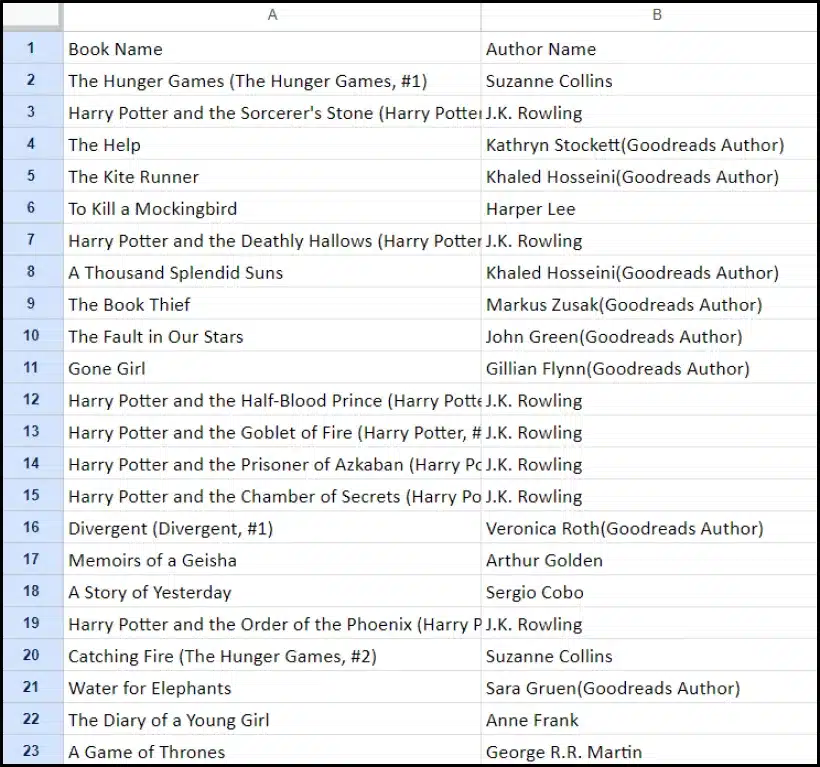

このチュートリアルでは、goodreads.com から書籍のリストを抽出する手順を説明します。理解を助けるために、Web サイトのページ レイアウトを視覚的に表現します。

次に、ChatGPT を使用してデータを効果的に収集するために必要な重要な手順について説明します。

ChatGPTアカウントの設定

ChatGPT アカウントの設定手順は簡単です。ChatGPT ログイン ページに移動し、サインアップ オプションを選択します。または、利便性を高めるために、Google アカウントを使用してサインアップすることもできます。

登録が完了すると、チャット インターフェイスにアクセスできるようになります。会話を開始するには、指定されたテキスト ボックスに質問またはメッセージを入力するだけです。

ChatGPT の効果的なプロンプトの作成

Web スクレイピングなどのプログラミング タスクで ChatGPT の支援を求める場合、プロンプトの明確さと詳細さが最も重要です。プログラミング言語、および必要なツールやライブラリを明示的に指定します。さらに、操作する予定の Web ページの特定の要素を明確に識別します。

同様に重要なのは、プログラムの望ましい結果と、遵守する必要がある特定のコーディング標準または要件を指定することです。

たとえば、BeautifulSoup ライブラリを使用した Python Web スクレーパーの開発を要求するこの例示的なプロンプトを検討してください。

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.これに続いて、ChatGPT によって適切なコード スニペットが生成されます。

生成されたコードの評価

ChatGPT がコードを提供したら、それを徹底的に確認することが重要です。余分なライブラリが含まれていないことを検証し、コードが正しく機能するために必要なすべてのパッケージが利用可能であることを確認します。

コードに問題や矛盾が見つかった場合は、遠慮なく ChatGPT に連絡して調整を依頼するか、必要に応じて完全に書き直してください。

スクレーパーの実装

確認後、提供されたコードをコピーし、適切な機能があるかどうかを確認するために試用を実行します。Web スクレイパー コードの例を次に示します。

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")スクレイピングされたデータのサンプル出力を以下に示します。

ChatGPT で Web スクレイピング プロジェクトを強化する: 高度なテクニックと考慮事項

提供されたコードから明らかなように、BeautifulSoup を使用して Python Web スクレイパーを開発することで、大きな進歩を遂げました。このスクリプトは、指定された Goodreads Web ページからデータを効率的に収集するための優れた出発点です。次に、Web スクレイピング プロジェクトをさらに強化するための高度な側面を詳しく見ていきましょう。

効率性を高めるためのコードの最適化

効率的なコードは、特に大規模なタスクの場合、Web スクレイピングを成功させる上で不可欠です。スクレイパーのパフォーマンスを向上させるには、次の戦略を検討してください。

- フレームワークとパッケージを活用する: Web スクレイピングを高速化できるフレームワークとパッケージに関するアドバイスを求めます。

- キャッシュ技術を活用する: 以前に取得したデータを保存するキャッシュを実装し、冗長なネットワーク呼び出しを削減します。

- 同時実行または並列処理を採用する: このアプローチでは、複数のタスクを同時に処理することで、データの取得を大幅に高速化できます。

- 不要なネットワーク呼び出しを最小限に抑える: ネットワークの使用を最適化するために、必要なデータのみを取得することに重点を置きます。

動的Webコンテンツの処理

最近の多くのウェブサイトでは、動的なコンテンツ生成技術が使用されており、多くの場合 JavaScript に依存しています。ChatGPT は、このような複雑な問題を解決するために次のような方法で役立ちます。

- ヘッドレスブラウザを活用する: ChatGPT は、ヘッドレス ブラウザを使用して動的コンテンツをスクレイピングする方法を説明します。

- ユーザーインタラクションの自動化: シミュレートされたユーザーアクションを自動化して、複雑なユーザーインターフェイスを持つ Web ページと対話することができます。

コードのリンティングと編集

クリーンで読みやすいコードを維持することは非常に重要です。ChatGPT はいくつかの方法で役立ちます。

- ベストプラクティスを提案: ChatGPT は、読みやすさと効率性を高めるためのコーディング標準とプラクティスを推奨できます。

- コードをリントする: スクリプトの整理と最適化に関する提案を得るために、ChatGPT に「コードの lint」を依頼します。

プロキシサービスによる制限の克服

ChatGPT は強力なツールですが、厳格なセキュリティ対策が施されたサイトから Web データをスクレイピングする場合は、制限があることを認識しておくことが重要です。CAPTCHA やレート制限などの課題に対処するには、OneProxy などのプロキシ サービスの使用を検討してください。これらのサービスには次の機能があります。

- 高品質プロキシプール: 優れた評判とパフォーマンスを備えたプレミアム プロキシ プールにアクセスできます。

- 信頼性の高いデータ取得: リクエストがレート制限されないようにし、必要なデータへの一貫したアクセスを維持します。

WebスクレイピングにおけるOneProxyの応用

OneProxy を利用すると、Web スクレイピング機能が大幅に強化されます。さまざまなプロキシを介してリクエストをルーティングすることで、次のことが可能になります。

- レート制限と CAPTCHA をバイパス: OneProxy は、一般的なスクレイピング防止対策を回避するのに役立ちます。

- 正確で無制限の Web データにアクセス: OneProxy は、堅牢なプロキシ ネットワークにより、信頼性が高く中断のないデータ アクセスを保証します。

ChatGPT のパワーと OneProxy などのツールの戦略的な使用を組み合わせ、コーディングと Web スクレイピングのベスト プラクティスに従うことで、さまざまな Web ソースから必要なデータを効率的かつ効果的に収集できます。

結論: WebスクレイピングにおけるChatGPTのパワーを解き放つ

要約すると、ChatGPT は Web スクレイピングの分野で極めて重要なツールとして登場し、さまざまな機会を最前線にもたらします。コードを生成、改良、強化する機能は、初心者と熟練した Web スクレイパーの両方にとって不可欠です。

ChatGPT の Web スクレイピングにおける役割は、コード生成だけにとどまりません。洞察に富んだヒントの提供、複雑な Web ページの処理、効率的なスクレイピングのベスト プラクティスに関するアドバイスまで、その役割は多岐にわたります。テクノロジーが進化するにつれ、Web スクレイピング タスクの簡素化と高度化に対する ChatGPT の貢献はますます重要になっています。

これは、ChatGPT のような高度な AI ツールを活用した Web スクレイピングが、個人の趣味人から大規模なデータ アナリストまで、幅広いユーザーにとってよりアクセスしやすく、効率的で効果的になる新しい時代の始まりです。

今後のスクレイピングの成功と革新的な取り組みを祈っています。スクレイピングを楽しんでください!