ChatGPT di OpenAI rappresenta un passo avanti significativo nella tecnologia AI. Questo chatbot altamente sofisticato, alimentato dal modello linguistico GPT-3, è ora accessibile a un pubblico globale.

ChatGPT si distingue come uno strumento di conversazione intelligente, essendo stato addestrato su una gamma completa di dati. Ciò lo rende eccezionalmente adattabile, in grado di affrontare una miriade di sfide in uno spettro di campi.

Questa guida ha lo scopo di istruirti sull'utilizzo di ChatGPT per costruire efficaci web scraper Python. Inoltre, forniremo suggerimenti e tecniche essenziali per perfezionare ed elevare il calibro della programmazione del tuo scraper.

Intraprendiamo un'esplorazione dell'utilizzo di ChatGPT per il web scraping, scoprendone le potenzialità e le applicazioni pratiche.

Implementazione del Web Scraping tramite ChatGPT

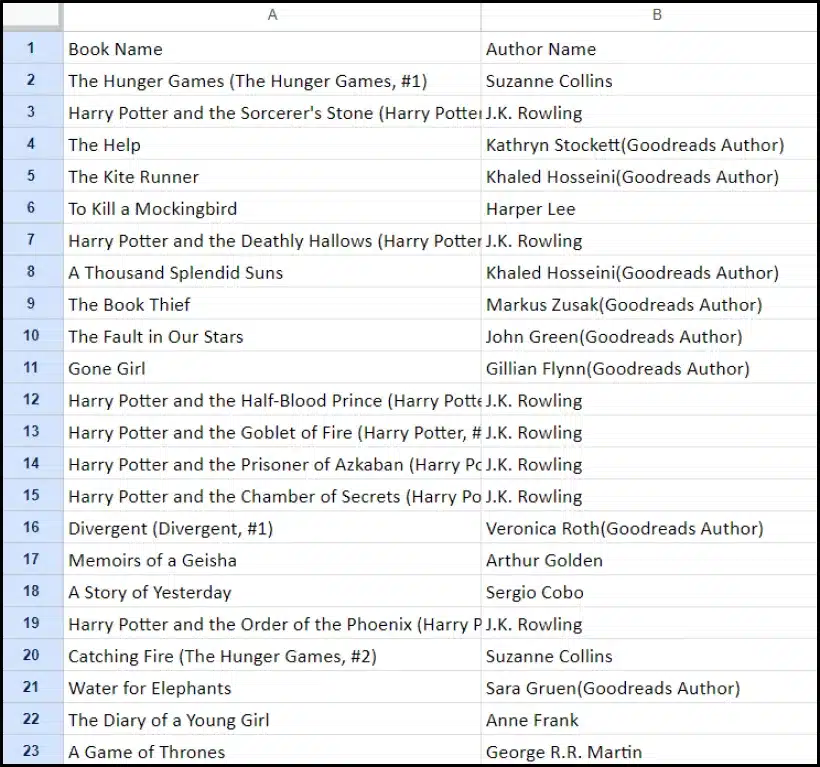

Questo tutorial ti guiderà attraverso il processo di estrazione di un elenco di libri da goodreads.com. Presenteremo una rappresentazione visiva del layout della pagina del sito Web per facilitare la comprensione.

Successivamente, descriviamo i passaggi critici necessari per raccogliere dati utilizzando ChatGPT in modo efficace.

Configurazione di un account ChatGPT

Il processo di creazione di un account ChatGPT è semplice. Vai alla pagina di accesso di ChatGPT e seleziona l'opzione di registrazione. In alternativa, per maggiore comodità, puoi scegliere di registrarti utilizzando il tuo account Google.

Una volta completata la registrazione, avrai accesso all'interfaccia della chat. Avviare una conversazione è semplice come inserire la query o il messaggio nella casella di testo fornita.

Creazione di un suggerimento efficace per ChatGPT

Quando si richiede l'assistenza di ChatGPT in attività di programmazione come il web scraping, la chiarezza e il dettaglio nelle richieste sono fondamentali. Dichiarare esplicitamente il linguaggio di programmazione, insieme a eventuali strumenti o librerie necessari. Inoltre, identifica chiaramente gli elementi specifici della pagina web con cui intendi lavorare.

Altrettanto importante è specificare il risultato desiderato del programma ed eventuali standard o requisiti di codifica specifici che devono essere rispettati.

Ad esempio, considera questo prompt esemplare che richiede lo sviluppo di un web scraper Python utilizzando la libreria BeautifulSoup.

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.Successivamente, ChatGPT dovrebbe generare uno snippet di codice adatto.

Valutazione del codice generato

Una volta che ChatGPT fornisce il codice, è fondamentale esaminarlo attentamente. Verificare che non includa librerie superflue e verificare che siano disponibili tutti i pacchetti necessari affinché il codice funzioni correttamente.

Se riscontri problemi o discrepanze con il codice, non esitare a contattare ChatGPT per modifiche o una riscrittura completa, se necessario.

Implementazione del raschietto

Dopo la revisione, copiare il codice fornito ed eseguire una prova per garantirne il corretto funzionamento. Ecco un esempio di come potrebbe apparire il codice del web scraper.

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

print(f"Failed to retrieve data. Status code: {response.status_code}")Di seguito è riportato l'output di esempio dei dati raschiati.

Migliorare il tuo progetto di Web Scraping con ChatGPT: tecniche avanzate e considerazioni

Hai fatto progressi significativi sviluppando uno scraper web Python utilizzando BeautifulSoup, come evidente nel codice fornito. Questo script è un eccellente punto di partenza per raccogliere in modo efficiente i dati dalla pagina Web Goodreads specificata. Ora approfondiamo alcuni aspetti avanzati per migliorare ulteriormente il tuo progetto di web scraping.

Ottimizzazione del codice per l'efficienza

Un codice efficiente è vitale per il successo del web scraping, in particolare per attività su larga scala. Per migliorare le prestazioni del tuo raschietto, considera le seguenti strategie:

- Sfruttare framework e pacchetti: Chiedi consigli su framework e pacchetti che possono accelerare il web scraping.

- Utilizzare tecniche di memorizzazione nella cache: Implementa la memorizzazione nella cache per salvare i dati recuperati in precedenza, riducendo le chiamate di rete ridondanti.

- Utilizzare la concorrenza o l'elaborazione parallela: Questo approccio può accelerare notevolmente il recupero dei dati gestendo più attività contemporaneamente.

- Riduci al minimo le chiamate di rete non necessarie: Concentrati sul recupero solo dei dati essenziali per ottimizzare l'utilizzo della rete.

Gestione dei contenuti Web dinamici

Molti siti Web moderni utilizzano tecniche di generazione di contenuti dinamici, spesso basandosi su JavaScript. Ecco alcuni modi in cui ChatGPT può aiutarti a superare tali complessità:

- Utilizza browser senza testa: ChatGPT può guidarti nell'utilizzo dei browser headless per lo scraping di contenuti dinamici.

- Automatizza le interazioni degli utenti: Le azioni utente simulate possono essere automatizzate per interagire con pagine Web dotate di interfacce utente complesse.

Linting e modifica del codice

Mantenere un codice pulito e leggibile è fondamentale. ChatGPT può aiutare in diversi modi:

- Suggerire le migliori pratiche: ChatGPT può consigliare standard e pratiche di codifica per migliorare la leggibilità e l'efficienza.

- Linta il tuo codice: Richiedi a ChatGPT di "linting the code" per suggerimenti su come riordinare e ottimizzare il tuo script.

Superare le limitazioni con i servizi proxy

Sebbene ChatGPT sia uno strumento potente, è essenziale riconoscere le limitazioni quando si estraggono dati Web da siti con rigorose misure di sicurezza. Per affrontare sfide come i CAPTCHA e la limitazione della velocità, prendi in considerazione l'utilizzo di servizi proxy come OneProxy. Loro offrono:

- Pool di proxy di alta qualità: Accesso a un pool premium di proxy con reputazione e prestazioni eccellenti.

- Recupero affidabile dei dati: Garantire che le tue richieste non siano limitate in termini di velocità, mantenendo così un accesso coerente ai dati richiesti.

Applicazione di OneProxy nel Web Scraping

L'utilizzo di OneProxy può migliorare in modo significativo le tue capacità di web scraping. Instradando le tue richieste attraverso vari proxy, puoi:

- Bypassare la limitazione della velocità e i CAPTCHA: OneProxy può aiutare a eludere le comuni misure anti-scraping.

- Accedi a dati Web accurati e illimitati: Con una solida rete proxy, OneProxy garantisce un accesso ai dati affidabile e ininterrotto.

Combinando la potenza di ChatGPT con l'uso strategico di strumenti come OneProxy e aderendo alle migliori pratiche di codifica e web scraping, puoi raccogliere in modo efficiente ed efficace i dati di cui hai bisogno da un'ampia gamma di fonti web.

Conclusione: liberare la potenza di ChatGPT nel Web Scraping

In sintesi, ChatGPT emerge come uno strumento fondamentale nel regno del web scraping, portando in primo piano una moltitudine di opportunità. Le sue capacità di generare, perfezionare e migliorare il codice sono indispensabili sia per i web scraper principianti che esperti.

Il ruolo di ChatGPT nel web scraping non si limita solo alla generazione di codice; si estende alla fornitura di suggerimenti approfonditi, alla gestione di pagine Web complesse e persino alla consulenza sulle migliori pratiche per uno scraping efficiente. Con l'evolversi della tecnologia, il contributo di ChatGPT alla semplificazione e al progresso delle attività di web scraping sta diventando sempre più vitale.

Ciò segna una nuova era in cui il web scraping, alimentato da strumenti avanzati di intelligenza artificiale come ChatGPT, diventa più accessibile, efficiente ed efficace per un'ampia gamma di utenti, dai singoli hobbisti agli analisti di dati su larga scala.

Brindiamo agli sforzi di raschiatura innovativi e di successo del futuro: buon raschiamento!