OpenAI 的 ChatGPT 代表了人工智能技术的重大飞跃。这款由 GPT-3 语言模型驱动的极其复杂的聊天机器人现已面向全球用户开放。

ChatGPT 是一款出色的智能对话工具,经过了全面的数据训练。这使其具有极强的适应性,能够解决各个领域的无数挑战。

本指南旨在指导您使用 ChatGPT 构建有效的 Python 网络爬虫。此外,我们还将提供必要的提示和技巧来完善和提升爬虫编程的质量。

让我们开始探索使用 ChatGPT 进行网络抓取,发掘其潜力和实际应用。

通过 ChatGPT 实现网页抓取

本教程将指导您完成从 goodreads.com 提取图书列表的过程。我们将提供网站页面布局的视觉表示以帮助您理解。

接下来,我们概述有效使用 ChatGPT 收集数据所需的关键步骤。

设置 ChatGPT 账户

设置 ChatGPT 帐户的过程很简单。导航到 ChatGPT 登录页面并选择注册选项。或者,为了更加方便,您可以选择使用您的 Google 帐户注册。

完成注册后,您将可以访问聊天界面。发起对话非常简单,只需在提供的文本框中输入您的查询或消息即可。

为 ChatGPT 制作有效的提示

在寻求 ChatGPT 帮助完成网页抓取等编程任务时,提示的清晰度和细节至关重要。明确说明编程语言以及任何必要的工具或库。此外,明确标识您打算使用的网页的特定元素。

同样重要的是指定程序的期望结果以及需要遵守的任何特定编码标准或要求。

例如,考虑这个示例提示,要求利用 BeautifulSoup 库开发一个 Python 网络抓取工具。

Craft a web scraper in Python using the BeautifulSoup library.

Target Website: https://www.goodreads.com/list/show/18816.Books_You_Must_Read_

Objective: Extract the names of books and their authors from the specified page.

Here are the required CSS selectors:

1. Book Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > a > span

2. Author Name: #all_votes > table > tbody > tr:nth-child(1) > td:nth-child(3) > span:nth-child(4) > div > a > span

Desired Output: Store the collected Book Names and Author Names in a CSV file.

Additional Requirements: Ensure proper handling of character encoding and the elimination of unwanted symbols in the output CSV.接下来,ChatGPT 应该生成合适的代码片段。

评估生成的代码

ChatGPT 提供代码后,彻底检查代码至关重要。验证代码不包含多余的库,并确认所有必要的软件包都可用于代码正常运行。

如果您遇到任何与代码相关的问题或差异,请随时联系 ChatGPT 进行调整或在必要时进行彻底重写。

实现你的爬虫

审核后,复制提供的代码并进行试运行以确保其功能正常。以下是网页抓取工具代码的示例。

import requests

from bs4 import BeautifulSoup

import csv

# Define the target URL

url = "https://www.goodreads.com/list/show/18816.Books_You_Must_Read_"

# Send an HTTP GET request to the URL

response = requests.get(url)

# Check if the request was successful

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

book_selector = "a.bookTitle span"

auth_selector = "span[itemprop='author']"

# Find all book names and author names using CSS selectors

book_names = soup.select(book_selector)

auth_names = soup.select(auth_selector)

# Create a list to store the scraped data

book_data = []

# Loop through the book names and author names and store them in the list

for book_name, author_name in zip(book_names, auth_names):

book_name_text = book_name.get_text(strip=True)

auth_name_text = auth_name.get_text(strip=True)

book_data.append([book_name_text, auth_name_text])

# Define the CSV file name

csv_filename = "book_list.csv"

# Write the data to a CSV file

with open(csv_filename, 'w', newline='', encoding='utf-8') as csv_file:

csv_writer = csv.writer(csv_file)

# Write the header row

csv_writer.writerow(["Book Name", "Author Name"])

# Write the book data

csv_writer.writerows(book_data)

print(f"Data has been scraped and saved to {csv_filename}")

else:

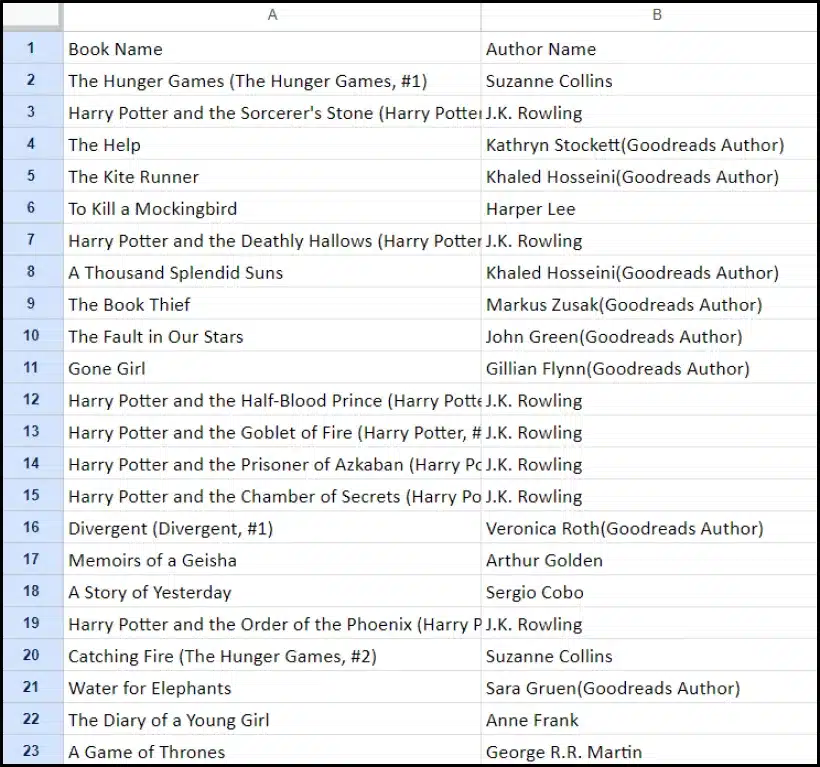

print(f"Failed to retrieve data. Status code: {response.status_code}")抓取的数据的示例输出如下所示。

使用 ChatGPT 增强你的 Web 抓取项目:高级技术和注意事项

通过使用 BeautifulSoup 开发 Python 网页抓取工具,您已经取得了重大进展,如提供的代码所示。此脚本是从指定的 Goodreads 网页高效收集数据的绝佳起点。现在,让我们深入研究一些高级方面,以进一步增强您的网页抓取项目。

优化代码以提高效率

高效的代码对于成功进行网页抓取至关重要,尤其是对于大型任务。为了提高抓取工具的性能,请考虑以下策略:

- 利用框架和包: 寻求有关可以加速网络抓取的框架和包的建议。

- 利用缓存技术: 实现缓存以保存以前获取的数据,减少冗余的网络调用。

- 采用并发或并行处理: 这种方法可以通过同时处理多个任务来显著加快数据检索速度。

- 尽量减少不必要的网络调用: 仅集中获取必要的数据以优化网络使用。

处理动态 Web 内容

许多现代网站都使用动态内容生成技术,通常依赖于 JavaScript。以下是 ChatGPT 可以帮助您解决此类复杂问题的一些方法:

- 利用无头浏览器: ChatGPT 可以指导您使用无头浏览器抓取动态内容。

- 自动化用户交互: 模拟用户操作可以自动化,以与具有复杂用户界面的网页进行交互。

代码检查和编辑

保持代码干净、易读至关重要。ChatGPT 可以通过多种方式提供帮助:

- 建议最佳实践: ChatGPT 可以推荐编码标准和实践,以提高可读性和效率。

- 检查代码: 请求 ChatGPT 'lint the code' 以获取有关整理和优化脚本的建议。

克服代理服务的限制

虽然 ChatGPT 是一款功能强大的工具,但在从采取严格安全措施的网站抓取网络数据时,必须承认其局限性。为了应对 CAPTCHA 和速率限制等挑战,请考虑使用 OneProxy 等代理服务。它们提供:

- 高质量代理池: 访问具有良好声誉和性能的优质代理池。

- 可靠的数据检索: 确保您的请求不受速率限制,从而保持对所需数据的一致访问。

OneProxy 在网页抓取中的应用

利用 OneProxy 可以显著增强您的网页抓取能力。通过各种代理路由您的请求,您可以:

- 绕过速率限制和 CAPTCHA: OneProxy 可以帮助规避常见的反抓取措施。

- 访问准确且无限的网络数据: 凭借强大的代理网络,OneProxy 可确保可靠且不间断的数据访问。

通过将 ChatGPT 的强大功能与 OneProxy 等工具的战略性使用相结合,并遵循编码和网络抓取的最佳实践,您可以高效、有效地从各种网络源收集所需的数据。

结论:释放 ChatGPT 在网页抓取中的强大力量

总而言之,ChatGPT 成为网络抓取领域的关键工具,带来了大量机遇。其生成、改进和增强代码的能力对于新手和经验丰富的网络抓取者来说都是必不可少的。

ChatGPT 在网页抓取中的作用不仅限于代码生成;它还扩展到提供深刻的提示、处理复杂的网页,甚至为高效抓取提供最佳实践建议。随着技术的发展,ChatGPT 对简化和推进网页抓取任务的贡献变得越来越重要。

这标志着一个新时代的开始,在这个时代,由 ChatGPT 等先进的 AI 工具提供支持的网络抓取对于从个人爱好者到大规模数据分析师的广泛用户来说变得更加容易访问、高效和有效。

祝愿未来的抓取工作取得成功和创新——抓取快乐!