Ein Cache-Server ist eine wichtige Komponente moderner Web-Infrastrukturen, die die Leistung und Effizienz von Web-Diensten verbessern soll. Er speichert häufig abgerufene Daten vorübergehend, sodass die Notwendigkeit, dieselben Informationen wiederholt von der Originalquelle abzurufen, verringert wird. Auf diese Weise beschleunigen Cache-Server den Datenabruf erheblich und verbessern das allgemeine Benutzererlebnis.

Die Entstehungsgeschichte des Cache-Servers und die erste Erwähnung davon

Das Konzept des Caching stammt aus den frühen Tagen der Computertechnik, als Arbeitsspeicher und Speicherplatz noch begrenzt waren. Die erste Erwähnung des Caching findet sich im Betriebssystem Multics in den 1960er Jahren. Es nutzte den Cache-Speicher, um häufig abgerufene Daten zu speichern, wodurch die Zeit für den Zugriff auf Informationen aus dem langsameren Hauptspeicher oder Festplattenspeicher verkürzt wurde.

Im Laufe der Jahre wurde mit dem Wachstum des Internets und der Webdienste die Notwendigkeit des Caching immer offensichtlicher. In den 1990er Jahren, mit dem Aufkommen des World Wide Web, begannen Webbrowser, Caching zu implementieren, um Webseitenelemente zu speichern, was ein schnelleres Laden der Seiten bei nachfolgenden Besuchen ermöglichte.

Detaillierte Informationen zum Cache-Server. Erweiterung des Themas Cache-Server

Ein Cache-Server ist eine spezielle Hardware oder Software, die Kopien häufig angeforderter Daten aus der Originalquelle speichert, um zukünftige Anfragen effizienter zu bearbeiten. Wenn ein Benutzer auf eine Website zugreift oder eine bestimmte Ressource wie Bilder, Videos oder Dateien anfordert, fängt der Cache-Server die Anfrage ab.

Wenn die angeforderte Ressource im Cache vorhanden ist, liefert der Cache-Server sie direkt an den Benutzer, ohne sie vom ursprünglichen Server abrufen zu müssen. Dieser Prozess reduziert die Latenz und den Bandbreitenverbrauch erheblich, da die Daten eine kürzere Distanz zurücklegen, was zu schnelleren Reaktionszeiten führt.

Cache-Server verwenden verschiedene Caching-Techniken, beispielsweise:

- Web-Caching: Zwischenspeichern von Webseiten und den zugehörigen Elementen (HTML, CSS, JavaScript), um das Laden der Website für Benutzer zu beschleunigen.

- Content Delivery Network (CDN): CDNs sind eine Art verteiltes Cache-Server-Netzwerk, das Inhalte von mehreren Standorten weltweit speichert und bereitstellt. CDNs tragen zur Minimierung der Latenz bei und gewährleisten eine schnellere Bereitstellung von Inhalten, insbesondere für geografisch verteilte Benutzer.

- Datenbank-Caching: Zwischenspeichern häufig aufgerufener Datenbankabfragen und -ergebnisse, um den Datenabruf für Anwendungen zu beschleunigen.

- API-Caching: Zwischenspeichern von Antworten von APIs, um den Overhead auf Backend-Servern zu reduzieren und die API-Antwortzeiten zu verbessern.

Die interne Struktur des Cache-Servers. So funktioniert der Cache-Server

Die interne Struktur eines Cache-Servers umfasst normalerweise die folgenden Komponenten:

- Cache-Speicher: Hier werden die zwischengespeicherten Daten gespeichert. Dies kann je nach Anforderungen an die Zugriffsgeschwindigkeit mit verschiedenen Speichermedien wie RAM, SSDs oder einer Kombination aus beiden erfolgen.

- Cache-Manager: Der Cache-Manager übernimmt das Einfügen, Entfernen und Abrufen von Daten aus dem Cache-Speicher. Er verwendet Caching-Algorithmen, um zu bestimmen, welche Elemente beibehalten und welche ersetzt werden sollen, wenn der Cache seine Kapazitätsgrenze erreicht.

- Cache-Aktualisierungsmechanismus: Der Cache-Server muss mit dem Originalserver synchronisiert werden, um sicherzustellen, dass er die neueste Version der Daten enthält. Dies geschieht normalerweise mithilfe von Cache-Invalidierungs- oder Cache-Ablauftechniken.

- Cache-Steuerungsschnittstelle: Ein Cache-Server stellt häufig eine Schnittstelle oder API zum Verwalten und Steuern des Caching-Verhaltens bereit, z. B. zum Konfigurieren von Cache-Regeln, Leeren des Cache oder Bereinigen bestimmter zwischengespeicherter Elemente.

Der typische Arbeitsablauf eines Cache-Servers umfasst:

- Ein Benutzer fordert eine Ressource von einer Website oder Anwendung an.

- Der Cache-Server fängt die Anfrage ab und prüft, ob die Ressource in seinem Cache-Speicher verfügbar ist.

- Wenn die Ressource im Cache gefunden wird, liefert der Cache-Server sie direkt an den Benutzer.

- Wenn die Ressource nicht im Cache vorhanden ist oder abgelaufen ist, ruft der Cache-Server sie vom Originalserver ab, speichert eine Kopie im Cache-Speicher und liefert sie dann an den Benutzer.

- Der Cache-Server aktualisiert seinen Cache-Speicher regelmäßig, um die Genauigkeit und Relevanz der Daten sicherzustellen.

Analyse der Hauptfunktionen des Cache-Servers

Cache-Server bieten mehrere wichtige Funktionen, von denen sowohl Webdienste als auch Benutzer profitieren:

- Verbesserte Leistung: Durch die Verkürzung der Datenabrufzeit führen Cache-Server zu schnelleren Reaktionszeiten, kürzeren Seitenladezeiten und einem insgesamt besseren Benutzererlebnis.

- Bandbreiteneinsparungen: Zwischengespeicherte Daten werden lokal bereitgestellt, wodurch die Notwendigkeit wiederholter Datenübertragungen zwischen dem Benutzer und dem ursprünglichen Server minimiert wird. Dies reduziert den Bandbreitenverbrauch und die Kosten.

- Geringere Serverlast: Da Cache-Server einen erheblichen Teil der Anfragen verarbeiten, wird die Belastung des ursprünglichen Servers verringert, sodass dieser sich auf andere wichtige Aufgaben konzentrieren kann.

- Fehlertoleranz: Cache-Server können bei vorübergehenden Serverausfällen als Puffer fungieren. Wenn der ursprüngliche Server ausfällt, kann der Cache-Server weiterhin zwischengespeicherte Inhalte bereitstellen, bis der ursprüngliche Server wieder online ist.

- Geografische Verteilung: CDNs, eine Art Cache-Server-Netzwerk, können Inhalte an mehreren Standorten weltweit replizieren und so eine schnelle und zuverlässige Bereitstellung von Inhalten für Benutzer auf der ganzen Welt gewährleisten.

Arten von Cache-Servern

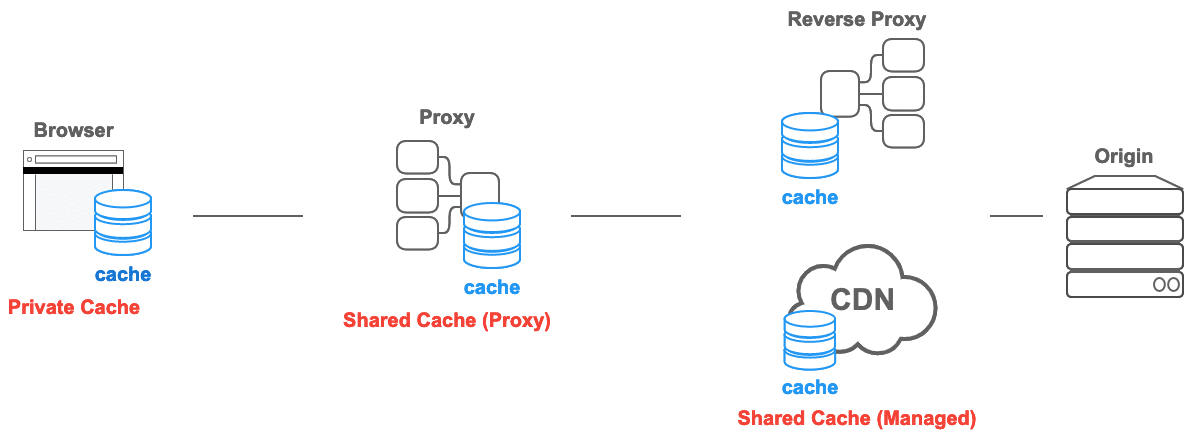

Cache-Server können nach ihrem Zweck und der Art der Daten, die sie zwischenspeichern, kategorisiert werden. Hier sind einige gängige Typen:

| Typ | Beschreibung |

|---|---|

| Web-Cache | Speichert Webseitenelemente (HTML, CSS, JavaScript), um das Laden der Website zu beschleunigen. |

| CDN | Verteilte Cache-Server, die Inhalte von mehreren Standorten weltweit bereitstellen. |

| Datenbank-Cache | Speichert häufig aufgerufene Datenbankabfragen und -ergebnisse im Cache, um einen schnelleren Datenabruf zu ermöglichen. |

| API-Cache | Zwischenspeichert Antworten von APIs, um die API-Antwortzeiten zu verbessern und die Backend-Last zu reduzieren. |

| Inhaltscache | Speichert Multimediainhalte (Bilder, Videos) im Cache, um Ladezeiten und Bandbreitennutzung zu reduzieren. |

Möglichkeiten zur Verwendung des Cache-Servers:

- Webbeschleunigung: Cache-Server werden verwendet, um das Laden von Websites für Benutzer zu beschleunigen, Absprungraten zu reduzieren und das SEO-Ranking zu verbessern.

- Inhaltsverteilung: CDNs speichern und verteilen Inhalte an mehrere Edge-Standorte und sorgen so für eine schnellere und zuverlässigere Bereitstellung von Inhalten.

- Datenbankleistung: Das Zwischenspeichern häufig aufgerufener Datenbankabfragen kann die Anwendungsleistung erheblich verbessern und die Datenbanklast reduzieren.

Probleme und Lösungen:

- Veralteter Cache: Zwischengespeicherte Daten können veralten oder veraltet sein. Cache-Server verwenden Cache-Ablauf- oder Ungültigkeitstechniken, um sicherzustellen, dass den Benutzern keine veralteten Inhalte bereitgestellt werden.

- Herausforderungen bei der Cache-Ungültigkeitserklärung: Wenn die Originaldaten aktualisiert werden, kann die Cache-Ungültigkeitserklärung komplex sein und erfordert eine sorgfältige Verwaltung, um die Bereitstellung veralteter Informationen zu vermeiden.

- Cachegröße und Auslagerungsrichtlinien: Cache-Server verfügen über eine begrenzte Speicherkapazität und die Auswahl effizienter Auslagerungsrichtlinien ist wichtig, um die wichtigsten Daten im Cache zu behalten.

Hauptmerkmale und andere Vergleiche mit ähnlichen Begriffen

| Charakteristisch | Cache-Server | Lastenausgleicher | Proxy Server |

|---|---|---|---|

| Funktion | Zwischenspeichern häufig abgerufener Daten, um den Abruf zu beschleunigen. | Verteilen Sie den Datenverkehr auf mehrere Server, um die Last auszugleichen. | Fungiert als Vermittler zwischen Clients und Servern und leitet Anfragen weiter. |

| Zweck | Optimieren Sie die Datenzugriffszeiten und reduzieren Sie die Serverlast. | Sorgen Sie für eine gleichmäßige Verteilung des Datenverkehrs und verhindern Sie eine Serverüberlastung. | Verbessern Sie Sicherheit, Datenschutz und Leistung für Clients und Server. |

| Typ | Software oder Hardware. | Normalerweise softwarebasiert. | Software oder Hardware. |

| Beispiele | Lack, Tintenfisch. | HAProxy, NGINX. | Apache, Nginx. |

Die Zukunft von Cache-Servern ist vielversprechend, angetrieben von Fortschritten in der Hardware- und Softwaretechnologie. Einige wichtige Trends und Technologien sind:

- Edge-Computing: Der Aufstieg des Edge Computing wird dazu führen, dass Cache-Server näher am Endbenutzer bereitgestellt werden, was die Latenz reduziert und die Leistung weiter verbessert.

- Maschinelles Lernen: Cache-Server können Algorithmen des maschinellen Lernens nutzen, um das Benutzerverhalten vorherzusagen und Daten proaktiv zwischenzuspeichern, wodurch die Cache-Trefferquoten verbessert werden.

- Unveränderliches Caching: Unveränderliches Caching stellt sicher, dass zwischengespeicherte Inhalte unverändert bleiben, und behebt so Herausforderungen bei der Cache-Konsistenz.

- Echtzeit-Daten-Caching: Das Zwischenspeichern von Echtzeit-Datenströmen wird für Anwendungen wie das IoT, bei denen eine geringe Latenz wichtig ist, von entscheidender Bedeutung sein.

Wie Proxy-Server verwendet oder mit Cache-Servern verknüpft werden können

Proxy-Server und Cache-Server werden häufig gemeinsam verwendet, um die Webleistung, Sicherheit und Privatsphäre zu verbessern. Proxy-Server fungieren als Vermittler zwischen Clients und Servern, während Cache-Server häufig abgerufene Daten speichern, um den Abruf zu beschleunigen. Die Kombination der beiden Technologien bietet mehrere Vorteile:

- Caching-Proxys: Proxyserver können als Caching-Proxys konfiguriert werden, sodass sie Inhalte zwischenspeichern und Clients bereitstellen können, ohne wiederholt Kontakt zum ursprünglichen Server aufnehmen zu müssen.

- Lastenausgleich und Caching: Lastenausgleichsmodule verteilen Clientanforderungen auf mehrere Server, während Caching-Proxys die Serverlast durch die Bereitstellung zwischengespeicherter Inhalte reduzieren.

- Sicherheit und Anonymität: Proxyserver können Clientanfragen anonymisieren und Cacheserver können häufig angeforderte Ressourcen sicher speichern.

Verwandte Links

Weitere Informationen zu Cache-Servern finden Sie in den folgenden Ressourcen:

- Caching-Tutorial für Webautoren und Webmaster

- So funktionieren CDNs

- Die Apache HTTP Server-Dokumentation

Denken Sie daran, dass Cache-Server eine grundlegende Komponente in der modernen Webarchitektur sind, da sie den Datenabruf optimieren und das allgemeine Benutzererlebnis verbessern. Durch die strategische Implementierung von Cache-Servern können Websites und Anwendungen schnellere Ladezeiten und eine geringere Bandbreitennutzung erreichen und die Belastung der Ursprungsserver verringern, was letztendlich zu einer höheren Benutzerzufriedenheit und einer höheren Effizienz für Webdienstanbieter führt.